Kaum eine CSI-Folge in der nicht ein Ermittler aus einem pixeligen Bildauschnitt von einer Überwachungskamera ein hochaufgelöstes einwandfreies Portraitfoto mit dem Täter generiert. „Zoom mal ran, die rechte Ecke oben!“, sagt einer meistens. „Und: Bekommst du es noch besser?“. So etwas ähnliches funktioniert, aber das Ergebnis muss nicht die echte Person zeigen. Es zeigt eine unter Wahrscheinlichkeiten und Erfahrungen konstruierte Version.

Schlagwort: Google

-

Amerikanische Technologieunternehmen berichten Q2 Ergebnisse

In der letzten Woche des Monats Juli haben viele Unternehmen Zahlen für das Quartal April/Mai/Juni vorgelegt.

Hierzulande wurde in der Presse Apple oft erwähnt, wo der Umsatz in Q2 so heftig „eingebrochen“ sei. Der Branchendienst Meedia, ein Spinoff des Handelsblatts, tut sich immer mit apokalyptisch-hämischer Berichterstattung hervor, wenn es um Apple geht.

Q2 2016 (Angaben in Mrd. US Dollar Umsatz Gewinn Alphabet (Google) 21,5 4,9 Amazon 30,4 0,9 Apple 42,4 7,8 Facebook 6,4 2,1 Intel 13,5 1,3 Microsoft 20,6 3,1 Verizon 30,5 0,7 Die Art der Berichterstattung in Deutschland greift häufig etwas kurz. Es gibt eben noch andere Unternehmen der Tech-Industrie neben Apple, Google und Facebook. Verizon ist ein solches Schwergewicht und in den vergangenen Wochen wegen des Teilkaufs von Yahoo aufgefallen.

Am Beispiel Intel sieht man, dass auch große etablierte Player sich Gedanken um die Zukunft machen müssen. Dort gab es schon nach den letzten Quartalszahlen Massenentlassungen. Sicher, weil der Markt durch Smartphones und andere mobile Geräte getrieben wird, der Desktop-PC und auch das klassische Notebook sind nicht mehr die großen Zugpferde, die sie in der Vergangenheit waren. Dafür konnte Intel in einem zweiten wichtigen Geschäftsbereich, als Hersteller für CPUs für Server zulegen.

Der Trend der zeit heißt nach wie vor „Cloud“. Microsoft und Amazon profitieren mit ihren Vierteljahresergebnissen genau davon.

-

Was man eben so an einem Brückentag tut: Google Adwords Zertifizierung

Schön, wenn man ab und an einen Brückentag hat. Ich habe die Zeit dazu verwendet, die Zertifizierung für Adword Partner zu erneuern. Mit Google Partners kann man sich von Google ein Zertifikat ausstellen lassen, nachdem man zwei Mal etwa 100 Fragen zu mindestens 80 Prozent richtig beantworten konnte.

-

Google IO 2015 – Hightlights der Entwicklerkonferenz

Ich habe eben den Livestream der Entwicklerkonferenz von Google verfolgt, die „I/O 2015“. Hier sind ein paar Neuigkeiten, die mir aufgefallen sind.

-

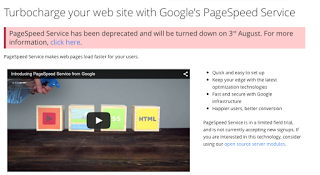

Google stellt den PageSpeed Service am 3.August 2015 ein

Unter https://developers.google.com/speed/pagespeed/service ist zur Zeit noch ein Google Service im Betastadium zu finden, der Webseitenbetreibern zu schnelleren Ladezeiten durch von Google gecachte Inhalte verhelfen soll. Dieser Service wird zum 3.August 2015 eingestellt.

-

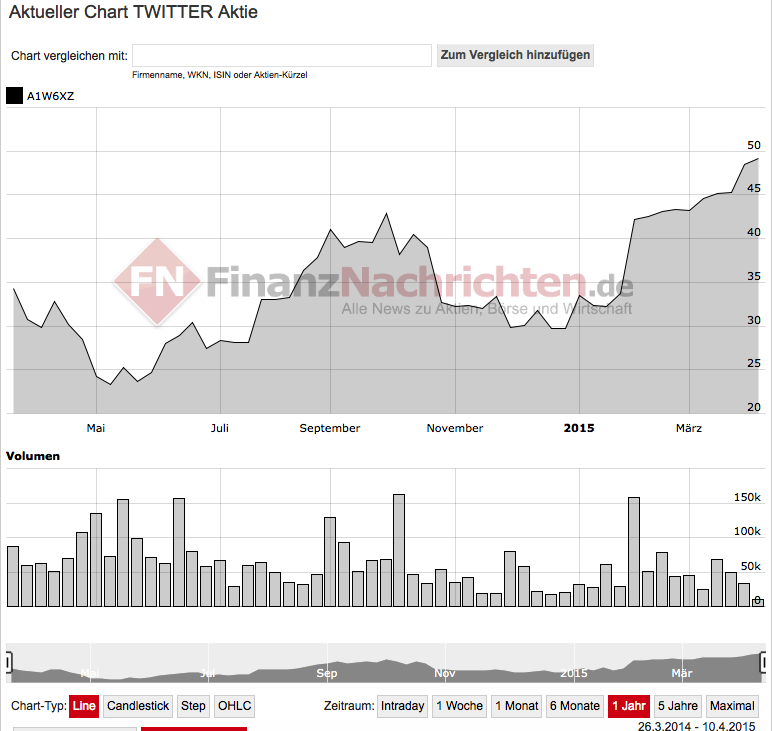

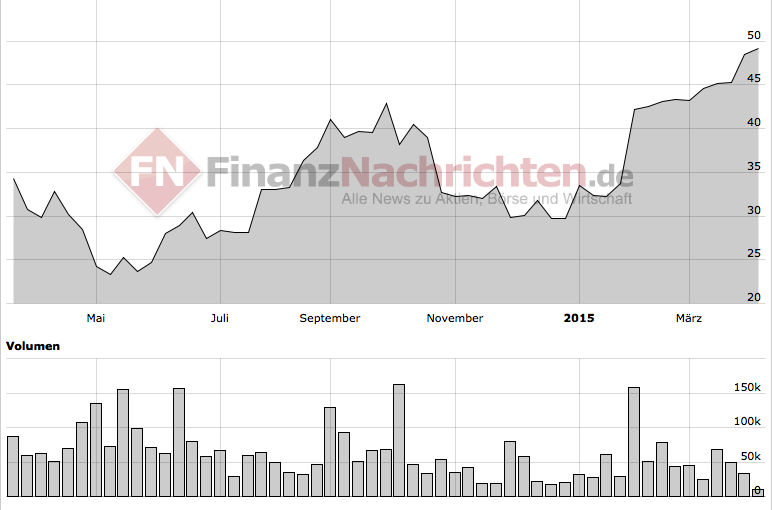

Jetzt noch Twitter Aktien kaufen?

Die Übernahmegerüchte haben Twitter einen neuen Schwung an der Börse gegeben:

https://www.googlewatchblog.de/2015/04/geruechtekueche-google-soll-feindliche-uebernahme-von-twitter-geplant-haben/Eine Annäherung zwischen Google und Twitter gab es bereits 2009. Vor kurzem war zu lesen, dass die Tweets wieder mit der Googlesuche gefunden werden können. Zeichen einer neuen Annäherung. Das soll mehr Traffic und mehr Sichtbarkeit für die Tweets bringen.Klar ist, dass Twitter Partner braucht. Es wird sogar schon gefragt, ob Twitter jemals profitabel werden könnte:Ein Problem ist wohl der hohe Anteil an Aktien, die für Mitarbeiter vorgesehen sind. Bei Twitter werden wohl recht viele Mitarbeiter zu einem vergleichsweise großen Teil in Aktien bezahlt.Google hatte bisher kein Glück mit den sozialen Netzwerken: Orkut, Buzz, Wave und – inzwischen muss man dies auch hinzufügen – Google Plus waren und sind keine Renner. Twitter wäre das einzige soziale Netzwerk, das man hinsichtlich Nutzerzahlen und Bedeutung mit Facebok vergleichen könnte. Von daher würde es zu Google passen. Allerdings kann Twitter unter Google auch schnell kaputt gehen, wenn es in alle möglichen Produkte und Dienste von Google zwangsintegriert werden muss.Klar ist, dass mit Twitter etwas passieren muss. Twitter kann nicht unendlich Verluste generieren. Im Vorfeld dürften die Gerüchte den Aktienpreis von Twitter weiter beflügeln. Wer jetzt noch keine Twitteraktien hat, ist wohl zu spät dran. -

Deutschland doch nicht technophob?

Die Cebit Seite hat eine t3n-Kolumne neu veröffentlicht. In diesem Artikel gab es eine Entgegnung auf die These von Jeff Jarvis (Artikel in der Zeit, Artikel auf medium.com, Interview in Profil, Österreich), wonach die Deutschen technophob wären: Sie verpixeln ihre Häuserfassaden in Google Maps, verbieten Uber und wehren sich gegen Facebook, nur als ein paar Beispiele genannnt.

Alltagstechnophobie oder Kommunikationskonservativismus?

Jeder kennt Leute, die tatsächlich technophob sind. Erst gestern mischte sich beim Mittagessen eine Frau am Nebentisch in unser Gespräch, in dem es um Facebook als Hoster für journalistische Inhalte ging. Sie behauptete steif und fest, auch nach 42 Lebensjahren kein Internet zu brauchen, auch keine E-Mail-Adresse. Man könne ja schließlich zum Amt gehen, wenn man etwas braucht oder in den Laden. Und interessante Menschen träfe man auch in seiner Umgebung.Das ist vielleicht nicht lupenrein technophob, eher konservativ-bewahrend („alles soll so bleiben wie es ist oder früher war“) und natürlich ein Einzelfall, aber illustrierend ist das dennoch.Deutsche PR-Abteilungen gelingt die generierung von Technobubbles – politisch aktive Schlagworte ohne viel Gehalt

Die Entgegnungen gegen die Jarvis-These lesen sich immer recht politisch und vielleicht ist eines der technischen Leistungen, die man in Deutschland gut hervorbringt, Technobubbles zu generieren, in dessen PR-Licht man sich dann sonnen kann: Beispielsweise Industrie 3.0 (oder auch 4.0), was immer das auch bedeuten soll.

Im zitierten Artikel, der belegen soll, dass es Internetphobie der Deutschen oder German Internetangst gar nicht gibt, verweist der Autor auf eine sehr starke Rolle der Rechte des Einzelnen in Europa und Deutschland, so wie das etwa beim Datenschutz und im Verbraucherschutz sichtbar werde.„Sowas wie Google oder Facebook gibt es in Europa nicht, weil wie die Datenschutz und Verbraucherrechte beachten“

In den USA zählten Menschen nicht, nur der Profit und die Freiheit von Großunternehmen. Damit wäre zumindest ein wenig erklärt, warum heute führende neue Unternehmen wie Google, Facebook, Amazon, Apple allesamt in den USA beheimatet sind. Was nicht mal stimmt. Weitere Internetgiganten, die uns nur nicht so auffallen, weil uns die jeweilige Kultur ferner liegt, kommen aus China (Alibaba), Russland (Yandex) oder auch Südkorea (Daum).

Gerade wenn man über die Cebit gegangen ist und nach deutschen Anbietern sucht, fallen eigentlich nur drei auf: SAP, Software AG, Datev – alle drei richten sich mit ihren Produkten an Unternehmen aus, nicht an Konsumenten. Das ist symptomatisch.In Deutschland: Individuelle Nutzer nicht im Blick der Konzerne

Das Vorzeigeunternehmen der „Deutschland AG“, Siemens, hat vor einigen Jahrzehnten noch versucht, auf einen fahrenden Zug aufzuspringen und Handies zu produzieren, in Kooperation mit Fuji sogar auch PCs und ist gescheitert. Gerade deutsche Unternehmen wären in den 80ern und 90ern des letzten Jahrhundert nie nie nie auf die Idee gekommen, so etwas wie einen Personal Computer auch nur anzudenken, die Amerikaner und dann die Japaner haben es gemacht. Die Europäer hinkten hinterher und waren bald aus dem Geschäft. Nie hätte ein deutsches Unternehmen angefangen, Bücher wie es Google tat und einen Riesenaufschrei produzierte, einzuscannen und damit zu digitalisieren. Auch Google Streetview kann man sich nicht als deutsches Projekt vorstellen. Wir hätten statt dessen 20 neue Gesetze und Vorschriften produziert und alles zerregelt, bis von der Idee nichts mehr übrig blieb. An solchen Dingen scheitert übrigens auch gerade die De-Mail.Also sind die Deutschen technophob und wenn ja, wie stark?

Empirisch ist das wohl noch nicht besonders gut untersucht. Nach einschlägigen Studien suche ich noch.

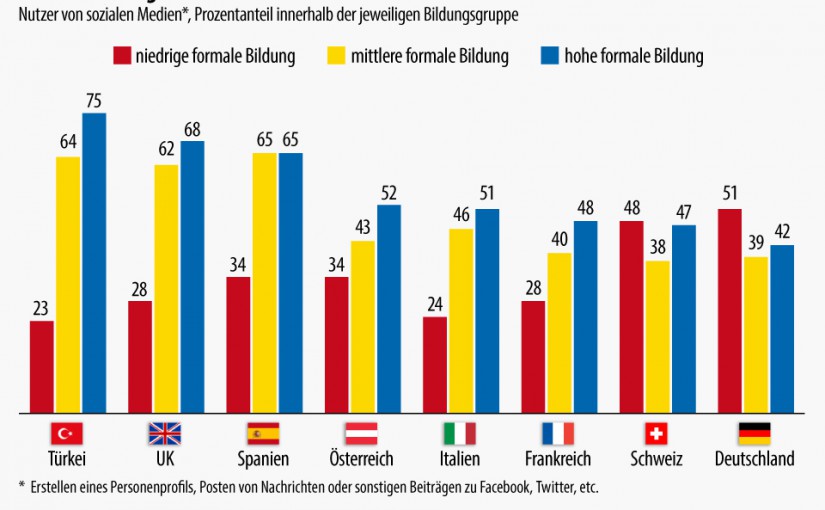

Vielleicht hilft für die Zwischenzeit ein Blick darauf, welche soziale Schichten in welchen Ländern social media nutzen. Die FAZ hat dazu einen kleinen Beitrag veröffentlicht, mit Bezug auf eine Statista-Grafik: In Deutschland ist der Anteil an Nutzern mit wenig formaler Bildung im Vergleich zur Türkei, UK, Spanien und auch Frankreich hoch. Dafür ist der Anteil der „Bildungsbürger“ wie die FAZ die Schicht mit mittlerer und hoher Bildung betitelt, niedrig. Die Unterschiede sind deutlich. Dies spricht in meinen Augen eher für die Jarvis These von der deutschen Internetskepsis.

Mehr Statistiken finden Sie bei Statista

-

BGH wirft Google Verletzung der Prüfpflicht beim Autocomplete-Feature in der Suche vor

Das sollte nach dem Urteil des Bundesgerichtshofs nicht mehr passieren, zumindest nicht, wenn sich dagegen jemand beschwert: Bei Eingabe von „bettina wulff“ in die Google Suche wurde bisher der Suchterm „bettina wulff rotlicht“ vorgeschlagen (Autocomplete).

Screenshot von heute, 14.5.2013 – 10:41 Uhr

Im konkreten Fall vor dem Bundesgerichtshof ging es um eine Revision, die ein Vertrieb von Nahrungsergänzungsmitteln und Kosmetika angestrengt hat, nachdem ein Berufungsgericht vorher keine Verletzung eines Persönlichkeitsrechts durch die Autocompleteergänzung mit „Scientology“ und „Betrug“ erkennen konnte.

Der Bundesgerichtshof sieht nicht in der algorithmischen Erfassung von beliebten Suchanfragen das Problem, sondern in der nicht erfolgten Überprüfung, ob Persönlichkeitsrechte verletzt werden.

Google wird für Deutschland wohl ein Feature erstellen müssen, mit dem betroffene User Beschwerde einreichen können, um dann rechtlich problematische Suchanfragen zumindest als Autocomplete-Vorschlag unterdrücken zu können.

-

Alle rätseln über Googles Rankingfaktoren

Suchmaschinenoptimierung ist wichtig. Die Aussage, dass man nur „exzellenten Content“ und „eine phantastische Nutzererfahrung“ präsentieren muss, um die eigene Seite im Web auffindbar zu machen, funktioniert vielleicht in einer idealen Welt. Realität ist, dass die meisten Internetuser ihre Websession mit Google starten und auf Suchergebnisse vertrauen, die Google auf den obersten Positionen zeigt. Die Seite, die dort steht, bekommt den Traffic.

Kein Wunder, dass also viele Webseitenbetreiber nach Wegen suchen, die eigene Site möglichst weit oben anzuzeigen. Es werden auch von vielen Dienstleistern Informationen angeboten, welche Faktoren wie relevant sind, um die Position in der Google-Suche bezogen auf ein Keyword vorherzusagen. Ein Beispiel dafür sind diese Rankingfaktoren, die Hanns Kronenberg zusammengestellt hat. Grafisch kann man dies wie in diesem Beispiel aufzeigen. Ein Ansatz ist, die wesentlichen Rankingfaktoren über Korrelationsanalysen herauszufinden. Eine Analyse dieser Art ist die von Searchmetrics. Hier werden die Zusammenhangsstärken aufgelistet, ich selbst hätte mir noch die Effektstärken dazu gewünscht. Erstaunlich an dieser Analyse ist, dass Korrelationen um .3 für Facebook Shares gefunden worden sind während die Anzahl der Backlinks (was gemeinhin als wichtigster Prädiktor aufgefasst wird) nur auf .23 kommt. Meiner Meinung nach sind diese Werte unbefriedigend, denn untersucht wird mit der Korrelation ja die gemeinsame Varianz, die bei einem r = .3 gerade mal 0,09 beträgt, das heißt dieser eine Prädiktor liefert gerade mal gerundet 10% Erklärung für die Suchmaschinenposition. Sicher funktioniert der Algorithmus komplexer und mir kam die Frage, warum man, wenn man schon das ganze Datenmaterial zur Verfügung hat, nicht ein paar andere Methoden anwendet, um die Vorhersage der Suchmaschinenposition zu verbessern. Vielleicht wäre es sinnvoll ein Verfahren wie die Pfadanalyse (es gibt ja viele hypothetische Modelle, die zeigen sollen wie Google funktioniert) oder auch eine konfirmatorische Faktorenanalyse. So könnte man feststellen, wie die inkrementelle Validität aussieht, das heißt welche zusätzliche Erklärung liefern die weiteren hypothetisch angenommenen Rankingfaktoren wirklich. Für eine Pfadanalyse muss man etwas mehr Aufwand treiben, denn die Software (wie AMOS von IBM) kostet recht viel an Lizenzgebühren (14 Tage gratis Test), aber eine Faktorenanalyse wird man noch bequem mit SPSS (oder eben PSPP) hinbekommen.