UPDATE des Artikels vom 23.6.2013

Am Wochenende hat sich der Skandal um die Überwachungsabitionen weiter ausgeweitet. Dies ist die dritte Woche in Folge, in der sich durch weitere Enthüllungen neue Ausmaße abzeichnen.

Langsam, finde ich, wird es Zeit für etwas genauere Analysen. Soweit ich das überblicke, ist noch nirgendwo eine verlässliche oder glaubwürdige Einschätzung erschienen, welchen Nutzen diese immens teuren Schnüffelaktionen überhaupt haben.

Okay, wir wissen, dass sich Geheimdienste In USA und UK Zugang zu den Glasfaserknoten und den wichtigen Netzknoten verschafft haben. Damit lässt sich der darüber fließende Internetverkehr grundsätzlich abhören und mitschneiden, also speichern. Da es sich um Daten auf recht rohem Niveau handelt, dürften recht aufwändige Analysen nötig sein, um den Fragmenten dieses Datenstroms einen Sinn zu geben.

Die Frage ist doch auch: Was lässt sich mit dieser Datensuppe eigentlich anfangen? Welche Möglichkeiten sind den Diensten überhaupt gegeben? Ich vermute, nach dem ich ein paar sowieso selten zu findende, weiterführende Artikel gelesen habe, dass man in der Lage sein wird, einzelne E-Mailkonten zu überwachen. Und in einigen Fällen wird es möglich sein, neben der reinen Aktivitätsmessung auch die Inhalte zu entschlüsseln bzw. zuzuordnen. Vielleicht erleben wir deswegen die häufigen unspezifischen Warnungen wie zuletzt vor Anschlägen auf Fanmeilen. Möglicherweise stellt man fest, dass über bekannte Mobilfunkverbindungen bzw. E-Mailadressen verstärkter Traffic läuft und darauf kann man schließen, dass die eine oder andere Gruppe etwas vor hat.

Vermutlich kann man auch im gespeichertem Datenbestand nachträglich Spuren finden, wenn man weiß, wonach man suchen soll. Dass Anschläge verhindert werden, wird behauptet. Bewiesen ist das glaube ich noch nicht. Offensichtlich ist der Versuch, Verbrechen mit Big Data Analysen zu verhindern viel viel schwieriger als gezielte Fahndung.

Für Deutschland auch kein Neuland. Bereits in den 1970ern versuchte das BKA per damals auch umstrittener Rasterfahndung der RAF auf die Spur zu kommen. Geholfen hat das wohl nicht viel.

Es wäre also sehr schön, es erschiene bald irgendwo im Spiegel oder in der Süddeutschen oder wo auch immer ein Beitrag, der einige Hintergründe etwas genauer ausleuchtet und nicht nur auf Empörung setzt.

UPDATE 6.7.2013

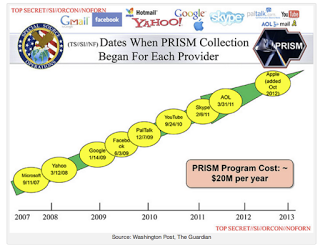

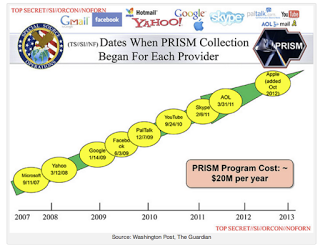

Inzwischen hat sich die PRISM-Geschichte weiterentwickelt. Wir wissen, dass der englische Geheimdienst und auch die NSA Glasfaserkabel anzapft. Wir wissen, dass auch die Franzosen und auch die Deutschen (BND am DECIX) abhören.

Was also macht man mit dieser Riesenmenge an Daten?

Es ist der Versuch, durch korrelative Zusammenhänge Erkenntnisse über die Zukunft ermitteln zu können. Eine Anwendung davon ist Predictive Policing, also der Versuch, aus vergangenen Mustern von Kriminalität Vorhersagen aus damit gewonnenen Zusammenhangsmodellen zu gewinnen. Dies ist in diesem Dokument genau beschrieben.

Der englische Guardian hat eine entsprechende Geschichte über prädiktive Analysen veröffentlicht: http://www.guardian.co.uk/science/2013/jul/01/how-algorithms-rule-world-nsa

Das Prinzip: Man sieht sich vorhandene Daten an, sucht nach inneren Zusammenhängen, die auch versteckt sein können, indem man geeignete statistische Verfahren anwendet (Stichwort: Strukturgleichungsmodelle) und kann dieses Modell darauf prüfen, wie gut es der Realität entspricht (Model Fit). Wenn dieser Model Fit hoch genug ist, taugt das Modell auch als Vorhersagemodell für zukünftige Zusammenhänge. Die Vorhersagekraft kann enorm sein, beängstigend und faszinierend zugleich, denn die Zusammenhänge sind ja tatsächlich, abgesehen von einer statistischen Fehlerwahrscheinlichkeit, tatsächlich vorhanden.

In vielen Lebensbereichen funktioniert predictive analysis sehr gut, gerade auch in kreativen Bereichen, von denen man naiv annehmen würde, hier kommt der menschliche freie, d.h. unvorhersehbare Wille zu tragen. Das ist offensichtlich nicht so.

So lässt sich mit guter Treffsicherheit vorausberechnen, ob ein Popsong eine Hit wird oder nicht. Ein Wedesigner names McCready entwickelte so ein Verfahren, das auf erweiterter Spektralkonvolution basiert.

Beschrieben sind solche Methoden, wie man oft liest, in „Automate This: How Algorithms Came to Rule Our World“ von Christopher Steiner.

Automate This: How Algorithms Came to Rule Our World