Affiliate Marketing ist heute, 2013, nicht nur nahezu vertane Liebesmüh‘, sondern kann für Webseitenbetreiber (Publisher) regelrecht gefährlich sein.

Für viele Webseitenbetreiber schien die Beteiligung an Affiliateprogrammen in den Doppelnullerjahren (ca. 2001 bis 2005) eine Möglichkeit zu sein, einige Euros mit einer Website zu generieren. Manchmal funktionierte das sogar, oftmals konnten wenigstens die Hostingkosten wieder eingefahren werden.

Damals wurde die eine oder andere Content – Site, die sich mit einem bestimmten Thema beschäftigt hat, tatsächlich noch in Suchmaschinen gefunden.

Niedergang des Affiliatebereichs

Heute sind die meisten Sites, die Affiliatelinks eingebaut haben, so weit abgewertet, dass diese fast nicht mehr sichtbar werden (Google nennt sie Thin Affiliates und rechnet diese dem Webspam zu). Mit der Teilnahme an Affiliateprogrammen ist kaum mehr Umsatz zu machen – von den absoluten Topplayern wie Dienste im Preisvergleichssegment mal noch abgesehen.

Das ist natürlich für Webseitenbetreiber schade, aber auch für Werbetreibende, denn: Gerade in Märkten und Nischen, in denen Onlinewerbung teuer ist, ist ein gut gesteuertes Affilieateprogramm in der Lage, neue Leads über Affiliates vergleichsweise günstig zu generieren.

Rolle der Affiliates in der Customer Journey

In der Customer Journey spielen Affiliateseiten, die einen Mehrwert bieten, z.B. indem sie den potentiellen Kunden den Weg durch den Tarifdschungel etwas einfacher machen, durchaus eine zunehmend wichtige Rolle (Stichwort Leadnutrition und Contentmarketing).

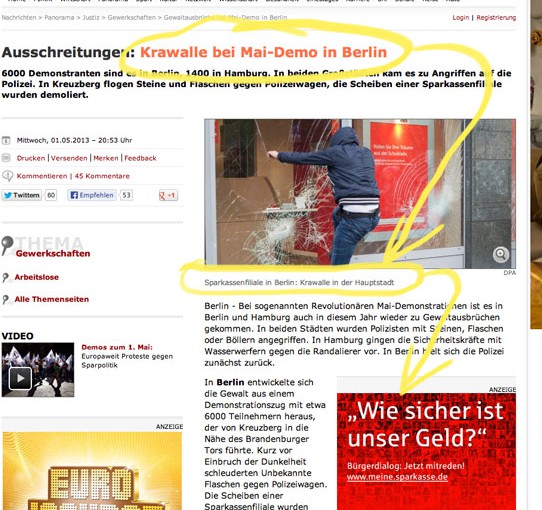

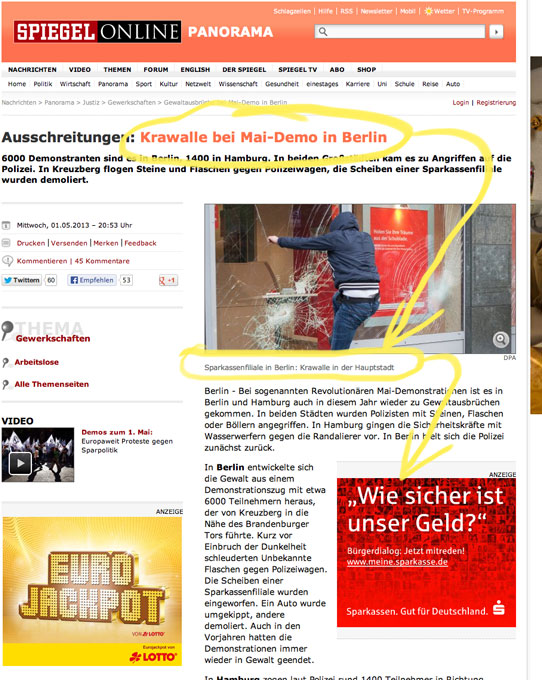

Völlig sinnlos wird es für Webseitenbetreiber allerdings, Programme einzusetzen, die Werbemittel mit juristisch umstrittenen Aussagen anbieten. Dann haftet der Affiliatepartner des Anbieters für Rechtsverstöße mit.

Ein aktuelles Beispiel liefert der Testsieger-Krieg zwischen Elitepartner und Parship. Beide Onlinedienste, die beide mit großen Budgets beworben werden, streiten sich im Frühjahr 2013 um die Rechtmäßigkeit, sich in der Werbung auf einen Stiftung-Warentest-Artikel beziehen zu dürfen.

Im Abmahnland Deutschland überziehen sie sich mit Verfügungen und ziehen vor Gericht, wollen aber (wie Parship) auf die Inkludierung der Testsiegerlogos in Onlineads und TV Werbespots nicht verzichten und lassen es auf einen Prozess ankommen. So verwendete Parship einen Bezug auf ein für Parship positives Testergebnis aus dem Stiftung Warentest Heft 3/2011. Der Konkurrent, ElitePartner, wendet ein, dass das Testergebnis schon zu alt sei, denn zwischenzeitlich sähe Parship ja ganz anders aus.

Beispiel: Die juristische Auseinandersetzung zwischen den Datingsites ElitePartner und Parship

Da sich deutsche Gerichte mit Internet- und Onlineangelegenheiten traditionell sehr schwer tun, ist das Risiko sehr hoch, zu unterliegen. Meist kann überhaupt nicht abgeschätzt werden, wie das angerufene Gericht die Angelegenheit sieht und urteilt.

Im aktuellen Fall erging am 23.5.2013 eine Einstweilige Verfügung an Parship, die Formulierungen in Bezug auf das Testergebnis 2011 mit Aussagen wie „Ich bin einfach gerne beim Testsieger“ oder „Ich habe einfach wenig Zeit, deshalb gleich zum Testsieger“ zu unterlassen. Moniert worden sind die TV Spots auf N24 und Tele5.

Parship hat dann offensichtlich allen Online-Affiliatepartnern eine E-Mail (Friendly-from „Rechtsabteilung“, was ein wenig wie Spam aussieht) und ein Schreiben zugestellt (mit normalem Brief), in dem bei Androhung von Schadensersatzansprüchen die Entfernung von „Testsieger“-Aussagen gefordert wird – was formaljuristisch wohl in Ordnung ist. Dem Affiliate-Thema hat man sicherlich keinen guten Dienst erwiesen.

Parship muss sich den Vorwurf gefallen lassen, es „darauf ankommen“ haben zu lassen. Dass die Testaussage umstritten ist, war bekannt. Offensichtlich sind die Testsieger-Aussagen aber so werbewirksam und konversionstreibend, dass man gerade in einer für die Branche so wichtigen Zeit wie dem Frühling nicht darauf verzichten wollte.

Man hat meiner Einschätzung nach mit einer Einstweiligen Verfügung gegen die TV-Spots gerechnet. Die Kosten für das Verfahren (Gegenwert schätzungsweise TV-Spotkosten für 3 bis 4 Tage) waren in die Werbekampagne wohl schon eingepreist. Wäre man vom Urteil überrascht worden, wäre die Reaktion und das Mailing an die Affiliatepartner nicht so unmittelbar erfolgt. Zudem ist es auch nicht das erste Mal, dass Parship diese Reaktionen zeigt.

Sites ständig prüfen, Kampagnen im Auge behalten

Was heißt das nun für die Affiliatepartner-Seiten: Es ist also laufend zu prüfen, welche Werbemittel der Werbepartner einsetzt, auch wenn diese vom Adserver stammen. Tückisch ist auch, wenn Screenshots und Thumbnails umstrittene Testsieger-Logos oder Formulierungen zeigen.

Das alles erfordert natürlich einiges an Aufwand und Aufmerksamkeit. Für ein bis zwei Sales im Vierteljahr lohnt sich das nicht.

Wenn das Affiliateprogramm eher verzichtbar ist, da es ohnehin nicht besonders performt, sollte man solche strittigen Programme vielleicht pausieren oder kündigen. Man muss sich dann überlegen, ob es das Risiko wert ist, eine Kampagne mitzugehen. Auch wenn für den Seitenbetreiber keine externen Kosten anfallen: Solche kurzfristigen Änderungen sind ausgesprochen lästig, bringen nichts und nerven nur.

Warum Gerichtskosten nicht lieber in Produktentwicklung investieren?

Ich frage mich, ob solche Kleinkriege, die auch auf den Rücken von Drittparteien ausgetragen werden, langfristig erfolgreich sein können.

Dieses in juristische Auseinandersetzung investierte Kapital könnte man ja auch für die Produktentwicklung hin zu einer Differenzierung oder zur Verbesserung der User Experience einsetzen. Dann würde sich vielleicht auch der Druck mindern, jeden kleinsten Schritt des Konkurrenten mit einem nahezu identischen Angebot argwöhnisch beobachten zu müssen.

So könnte man die Themen mobile Nutzung, verbessertes Matchmaking und sowie Aktivierung konsequenter angehen ehe es den internationalen Diensten gelingt, in Deutschland Fuss zu fassen oder die Social Media Plattformen mehr Dating-Fetaures etablieren.

Auch mit den Affiliatepartner könnte man konstruktiver zusammenarbeiten, sie mit Background füttern, Sonderaktionen fahren (nicht nur immer wieder die langweilige Rallye). Das machen manche Werbetreibenden schon besser als andere. ElitePartner hat für Mai 2013 eine Gutscheinaktion aufgelegt, während Parship Abmahnungen nach § 314 II BGB verschickt.