Warum haben sich geschlossene Plattformen wie Facebook, Linkedin, Twitter so verselbständigen können? Was wurde aus dem freien, offenen Web und sind propretäre, soziale Inhalte- und Sharingplattformen vielleicht ein Unfall der Hosting-Industrie? Zumindest sind sie deren ernsteste Bedrohung.

Ende der 1990er Jahre waren Computeranwender endlich in der Lage, digitale Inhalte im offenen Internet selbst zu veröffentlichen. Private Publishing im neuen, offenen World Wide Web war möglich. Nicht nur Studenten an Universitäten kamen in den Genuss dieser neuen Möglichkeit. Dank technischer Dienstleister, die das Massengeschäft übernahmen, war – zumindest in freien Gesellschaften – die eigene Webpräsenz für jedermann erschwinglich und möglich. Eine neue Branche entstand, die Hosting-Branche. Für kleines Geld konnte man sich ein Bündel aus Domainregistrierung, Serverspeicherplatz und E-Mail-Dienst abonnieren.

Private Publishing im WWW anno 1997

Zu dieser Zeit gab es viele technische Beschränkungen. Feedback von Usern einzuholen und zu verarbeiten, war schwer zu realisieren. Die eingesetzten Server waren noch nicht so leistungsfähig und Speicherplatz war noch teuer. Möglichkeiten für Interaktionen und dynamische Inhalte waren gegeben, längst aber nicht selbstverständlich und eher aufwändig. Die ersten Ansätze waren Gästebücher und Feedbackformulare, vielleicht auch Umfragen und ähnliche einfache Interaktionsmöglichkeiten.

Php & MySql brachten Anwendungen wie WordPress oder SugarCRM hervor

Erst mit der Verbreitung von PHP als quelloffene und somit kostenfreie Scriptsprache für serverseitig auszuführende Anweisungen und einer Datenbanklösung, in diesem Fall MySQL, war mehr machbar. So entstand das, was einige Zeit lang als Web 2.0 bezeichnet wurde, das „Mitmach-Web“. Speicher und Prozessorkapazität war billiger zu bekommen, die Rechenzentren wuchsen.

Viele Hosting-Unternehmen haben Technologien wie PHP und MySQL unterstützt, aber es versäumt, dem Kommunikations- und Vernetzungsbedarf der Webseitenbetreiber Rechnung zu tragen. Als User konnte sich einzelne Webdokumente im Browser bookmarken, aber die Konnektierung mit Usern war schwierig. RSS/Atom/XML-Feeds sollten Contents syndidizierbar machen, setzten aber wieder eine eigene Technologie voraus.

Dank der hohen Verbreitung von PHP und MySQL entwickelte sich eine florierende Open Source Landschaft, aus der so phantastische Anwendungen wie WordPress, Joomla! und Co hervorgingen. Content im Web bereit zu stellen, war nie einfacher.

Das Modell des zufällig surfenden Users

Webseiten bezogen sich mehr und mehr auf einen Gegenstand, eine Organisation, ein Unternehmen. Verlinkungen auf andere Domains wurden seltener. Das Hypertextprinzip wurde nicht mehr voll ausgeschöpft.

Die Folge: Inhalte im Web konnten zunächst nur per manuell editiertem Webkatalog, per Linkliste oder per Suchmaschine zugänglich gemacht werden. Suchmaschinen wurden zur meistgenutzten Anwendung. Dabei basiert Googles elementarer PageRank-Algorithmus vor allem auf der Idee des Hyperlinks und dem Modell des zufällig surfenden Users, der sich von Link zu Link hangelt. Ein Modell, das der Praxis zunehmend weniger entsprach. Es gab das Bild des Surfers bald nicht mehr.

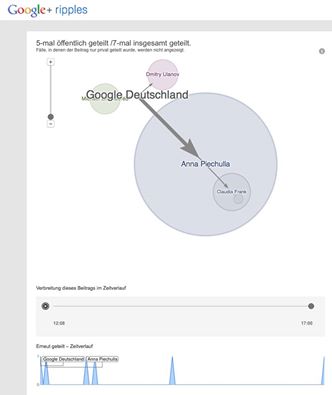

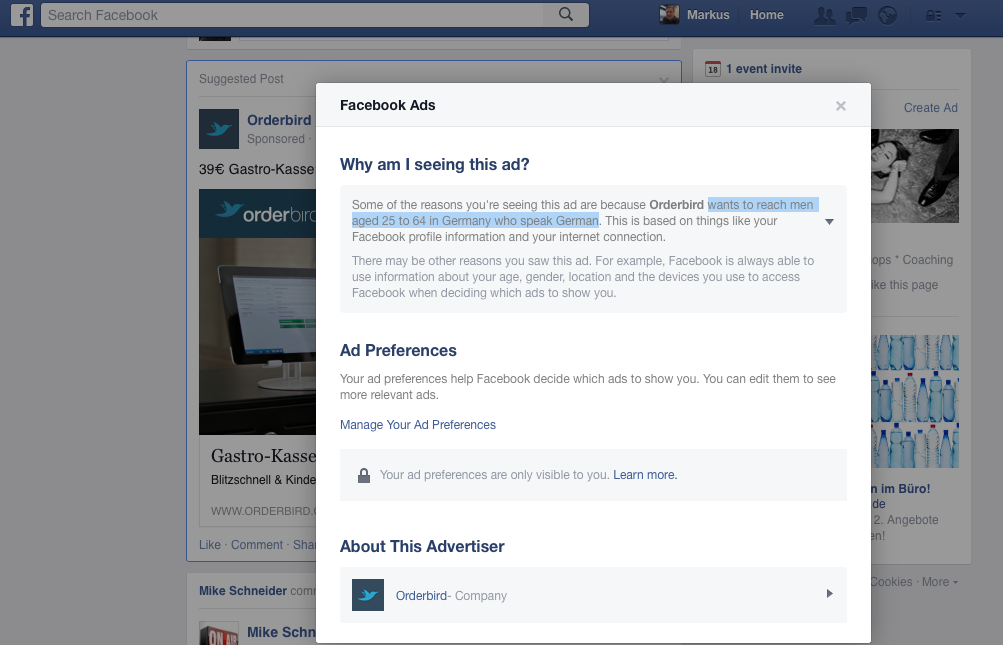

Während der großen Zeit der Google Suche war die Position auf der jeweiligen Suchergebnisseite für wichtige Keywords entscheidend. Der Traffic kommt heute mehr und mehr von Verlinkungen aus Beiträgen in Social Media Plattformen. Man liest einen Teaser online und klickt auf den Link, um den Rest der Story konsumieren zu können. Dabei ist die Story meist in Wort und Bild gekleidete Werbung, Native Advertising.

Native Advertising: Was ist Content, was ist Werbung?

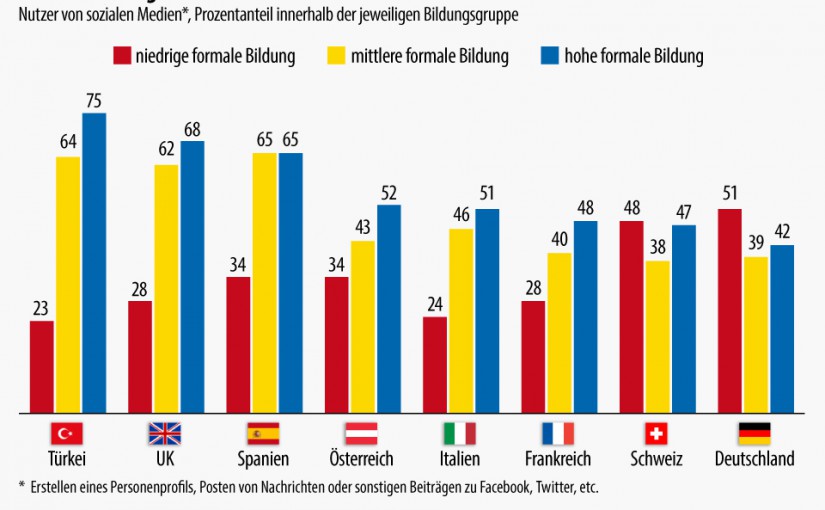

Einige Inhalteanbieter, Contentaggregatoren oder -distributoren gehen sogar dazu über, Inhalte nur über Facebook oder Linkedin zu platzieren und die Story gar nicht mehr auf die eigene Website zu schreiben. Leute, die Modeblogs anbieten, präferieren heute Instagram. Das ginge schneller, ist optischer und das Teilen der Inhalte ginge einfacher von statten. Vorteile, die nicht von der Hand zu weisen sind. Entscheidend ist, wieviele Augenpaare man erreicht, nicht wie viele Page Impressions auf der werbefinanzierten Webseite generiert werden. Dieses alte Web-Geschäftsmodell ist auch aufgrund der Verbreitung von Adblockern ohnehin in Gefahr. Fest steht, dass immer mehr Contents in geschlossene Plattformen verlagert wird. Das offene Web stirbt.

Steht man auf dem Standpunkt, dass das offene Web grundsätzlich ein Wert an sich ist, kann man fragen, wo ist was schief gelaufen?

Was ist aus dem offenen Web geworden – alles nur noch Timeline?

Natürlich haben auch die Apps für ohnehin schon proprietäre mobile Betriebssysteme dafür gesorgt, dass das offene Web zurückgedrängt wird. Den Hauptteil an Traffic auf Mobilgeräten erzeugen Apps, nicht der mobile Webbrowser.

Dank der Veröffentlichung von PHP und MySQL unter Open Source Lizenzen fanden Content Management System wie WordPress, Joomla!, Drupal und in Deutschland insbesondere auch Typo3 eine große Verbreitung. Dank der großen Verbreitung gab es auch große und agile Entwicklercommunities, die von Version zu Version überzeugende Features geliefert haben.

Die Open Source CMS – Lösungen wurden von Hostingunternehmen gerne aktiv angeboten. Für Kunden entstand durch die einfache Installation Mehrwert. Allerdings ist kein Benefit an die Entwicklercommunities zurückgeflossen. Sie waren von Spenden abhängig oder fanden einen Großsponsor, so dass neben der Community-Version bald eine lizenzpflichtige Version mit mehr Support und Funktionen erstellt wurde.

Wie hätte sich Open Source social software besser entwickeln können?

Einige CMS haben sich gut entwickelt, ebenso Tools wie Piwik oder CRM-Anwendungen. Leider haben es Social Media Plattformen nicht über Achtungserfolge hinaus geschafft. Leider war einem Friendica, einem Diaspora oder Elgg der große Durchbruch nicht vergönnt. Daneben gibt es noch eine Handvoll Social Media Frameworks mit einer dezentralen Struktur, die aber über das Betastadium nicht hinauskommen.

Vielleicht hätten sich die vielen Rechenzentrumsbetreiber und Hoster früher um soziale Netzwerke bemühen sollen. Es gibt offene Standards, die einen Austausch von Profildaten und Graphen ermöglichen. Damit könnte eine quelloffene, dezentrale Struktur ermöglicht werden, so wie es in Friendica auch angelegt ist.

Zu lange haben Hoster zugesehen und zumindest insgeheim darauf gehofft, dass social media ein schnell vorübergehendes Phänomen ist, dem die User bald überdrüssig werden würden. Ein Fehlschluss. Facebook und Co haben mit Hochdruck daran gearbeitet, für immer neue Zielgruppen interessant zu werden und zu bleiben. Ein Selbstläufer war das nicht, wie man am Schicksal von MySpace und StudiVZ unschwer erkennt.

Gibt es noch Leben in der Social Media Welt mit Open Source?

Die aktuelle Friendica Version trägt die Nummer 3.3.3, kann aber mit dem enormen Entwicklungstempo kommerzieller Plattformen nicht mithalten. Die User Experience ist mit Facebook oder Twitter einfach nicht zu vergleichen, von der Anzahl der Teilnehmer ganz abgesehen.

Das Problem des Sterbens des offenen Webs haben viele Unternnehmen erkannt. Einige haben sich in der Internet Defense Leage (https://www.internetdefenseleague.org) zusammengeschlossen. PHP, WordPress und Mozilla sind prominente Teilnehmer.

Eigentlich müsste auch Google daran interessiert sein, das offene, sich agil entwickelnde Web zu erhalten. Durch die Notwendigkeit, Milliarden Webseiten indizieren zu müssen, um Inhalte und Informationen zugänglich zu machen, hat Google viel Geld verdient. Die Anzeige von Werbebotschaften, die zu einer Sucheingabe passen, ist heute noch der mit Abstand größte Umsatzstrom für Google, der geringer wird, wenn immer mehr User über Social Media News und Informationen konsumieren und teilen.

Im Prinzip kann man Webseitenbetreiber nur ermutigen, die bisher betriebene Onlinepräsenz fortzuführen. Ein Verlass auf Social Media Plattformen zur Veröffentlichung eigener Contents ist gefährlich: Was passiert, wenn die Plattform eingestellt wird, die Richtlinien ändert oder das Geschäftsmodell? Dann sind im extremen Fall alle Inhalte und Kontakte verloren.