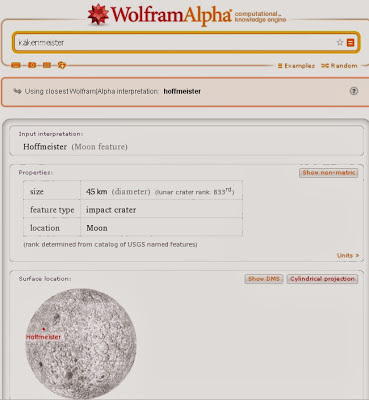

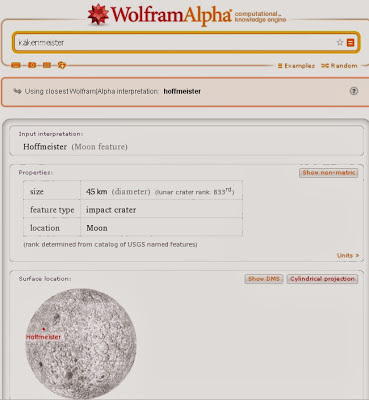

Was sucht man in einer Suchmaschine, die man kennenlernen will als erstes? Ja, seinen eigenen Namen.

Das habe ich bei Wolfram Alpha probiert. Ergebnis: Die Suche kennt die Zeichenkette „käkenmeister“ nicht und schlägt als naheliegenden Treffer „Hoffmeister“ vor, was offensichtlich der Name eines Krater auf dem Mond ist.

Kategorie: Uncategorized

-

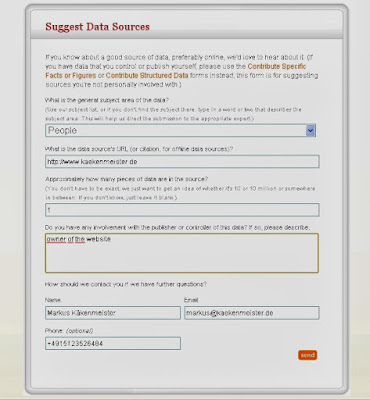

Wolfram Alpha kennt mich nicht – mal sehen, ob structured data hilft

Im Footer gibt es einige Möglichkeiten, selbst Daten zuzuliefern. Diese können auch vom Typ „People“ sein. Ganz klar präferiert Wolfram Alpha hier strukturierte Daten (schema.org). Ich biete also meine Website, die seit neustem strukturierte Daten enthält an:Nun muss man man sehen, wie lange es dauert, bis die Suche diesen Begriff als bekannt ausgibt und welche Informationen dann gezeigt werden.Viele halten strukturierte Daten für ein wesentliches Element künftiger Information retrieval Prozesse wie sie auch Suchmaschinen verwenden werden. -

Nervsoftware mit Flash-Update

Woran könnte es liegen, dass viele Windows – User darauf verzichten, Java- oder Flash-Updates einzuspielen, obwohl Sicherheitslücken in den alten Versionen bekannt geworden sind?

Ein Punkt könnte die forcierte, aber unerwünschte Installation von Drittparteisoftware wie von McAfee sein. Aktuelles Beispiel: Während man sich im Java-Update-Fenster schon darauf eingestellt hat, das bereits gesetzte Häkchen für den Zusatzsoftwarekram zu entfernen, verändert Adobe das Look & Feel der Installationsanleitung immer mal. Zur Zeit sieht es für das Update von Flash so aus:

Man sollte also in der Mitte das „Optionale Angebot“ für McAfee Security Scan Plus entfernen. Das ist lästig. Ich habe es zuerst auch übersehen und musste dann die Installation später abbrechen.

-

Traffic, den man nicht so gerne sieht

Es fällt ja schon auf, wenn neue Links in den Referrern stehen und nicht nicht nur die üblichen verdächtigten. Natürlich sieht man dann nach, was das für eine Site ist. Im Fall von ourmeets (dot) com ist das eine Pornoseite der hässlicheren Art, die so einfach ein bisschen Traffic generieren will – einfach weil man den Link mal aufruft.

Das ist schon anderen Blogbetreibern aufgefallen:

http://pithybits.blogspot.de/2013/10/why-is-ourmeetscom-visiting-my-website.html

http://from-the-sidelines.blogspot.de/2013/10/again-with-spam.html -

Ghost – einfach nur bloggen, aber erst mal installieren!

Einfach nur Bloggen – das ist die Leitidee der Macher der

neuen Blogsoftware Ghost.Ghost unterliegt wie viele andere Bloganwendungen einer

quelloffenen Lizenz. Jeder kann mit- und weiterentwickeln und – eigentlich ist

das ein Nebeneffekt – die Software kostenlos verwenden.Ghost ist nun öffentlich verfügbar. Wer jedoch glaubt, es

genüge, eine Zip-Datei herunterzuladen, diese zu entpacken, auf einem

Serverspeicherplatz abzulegen und „install.php“ auszuführen, wird enttäuscht.Ghost baut nicht auf PHP, sondern auf dem Node JS – Framework auf. Als

Datenbank ist standardmäßig SQLite vorgesehen, aber auch mit mySQL funktioniert

das. Node JS verwendet einen eigenen http-Server.Das hat einige Konsequenzen.Server benötigt Node.js

Zunächst muss der Server, egal, ob er unter Windows, MacOS

oder Linux läuft, node.js unterstützen. Falls dies nicht der Fall ist, muss man

die Installation vornehmen. Das ist von System zu System unterschiedlich. Ich habe

versucht, Ghost auf einem virtuellen Server mit Debian Linux zu installieren

und musste node.js natürlich zunächst nachinstallieren. Node.js ist auch noch recht frisch. Daher ändern sich die Releases schnell. Die offiziellen Repositories der Distributionen könnten veraltet sein. Vielleicht ist ein Selbstkompilieren hier tatsächlich besser.Für meinen virtuellen Server

habe ich mich nach dieser Installationsanleitung gerichtet, was gut geklappt

hat: http://www.sysadminslife.com/linux/howto-node-js-installation-unter-debian-squeeze-wheezy-ubuntu/Zunächst habe ich versucht, Git zu verwenden, was ich auch

erst nachinstallieren musste.Installation auch über git möglich

Da die Installation von Git auf dem V-Server

nicht reibungslos lief, habe ich die Installationsprozedur per Zip-Datei gewählt.

Ich habe das Installationspaket von github geladen, aber später gesehen, dass

Bitnami schon einen fertigen Stack bereit hält, was ich jedoch nicht

ausprobiert habe: http://bitnami.com/stacksWenn Node.js installiert ist, kann man sich an die

Installation von Ghost wagen. Also: Datei hochladen, entpacken (oder je nach

Geschmack auch umgekehrt), und dann in die Konsole (ich habe das als Root

vorgenommen) den Installationsbefehl ausführen: npm install –production .Weird error 8

Mit „NPM Start“ kann man dann sehen, ob sich Ghost starten

lässt. In den meisten Fällen, wenn man nicht gerade auf einem lokalen PC oder

Notebook installiert, wird man Fehlermeldungen erleben. Ich zum Beispiel

erhielt immer „Weird Error 8“, was auf Konfigurationsfehler hindeutet.Tatsächlich muss man in der config.js, die ich mit VI

bearbeitet habe, die Server-IP eintragen. Der standardmäßig eingetragene Port, 2368,

hat auf meinen VServer-Umfeld nicht funktioniert. Die URL lieferte einen

404-Fehler. Zudem soll ich den Apache stoppen, sagt ein Forumsbeitrag. Als Port habe ich 8080

gewählt. Mit diesen Parametern funktionierte der Aufruf auf die Startseite von

Ghost dann. Und auch der Apache ließ sich auf der gleichen virtuellen Maschine parallel betreiben. In diesem experimentellen Betrieb habe ich zumindest kein Stabilitätsproblem gesehen. Klar ist aber: Beide, also Apache oder Node.js können nicht auf Port 80 koexistieren.Andere Basistechnologie – bessere Performance? Es scheint so.

Grundsätzlich ist die Herangehensweise und die

Basistechnologie ganz anders und überhaupt nicht mit WordPress, Joomla oder

auch Drupal vergleichbar. Der Installationsaufwand erinnert an die frühen Tage

von Typo3. Auch damals mussten viele serverseitige Voraussetzungen erfüllt

sein, viele Konfigurationen waren vorzunehmen und das System lief längst nicht

auf normalen, handelsüblichen Shared-Hosting-Accounts. So ist es auch mit

Ghost. Man braucht definitiv Zugang zu den Serverressourcen, um Node.js

nachzuinstallieren. Kaum ein shared hoster stellt node.js defaultmäßig bereit.Wenn man die URL mit /ghost ergänzt, gelangt man ins

Backend. Hier soll man sich einen Blog-Account mit Namen und E-Mailadresse

anlegen. Der Mailtransportdienst kann in der Konfigurationsdatei festgelegt

werden, so dass der Accountinhaber benachrichtigt werden kann.Dann kann man bereits versuchen, seinen ersten Blogbeitrag

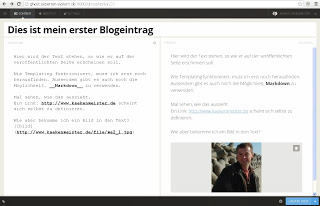

zu erstellen und zu posten.Ghost zeigt zwei Ansichten, das heißt unterteilt das

Browserfenster in vertikaler Richtung. Links gibt man den zu bloggenden Text

ein. Dabei kann man Markup verwenden, um die Formatierungen auszuzeichnen oder Bilder

einzufügen. Komfortablerweise gibt es dafür auch Tastaturshortcuts.Auf der rechten Seite des Eingabebildschirmfensters sieht

man dann eine Vorschauansicht, die sich selbst und das sehr schnell

aktualisiert.Überhaupt fällt auf, dass die Eingaben sehr schnell umgesetzt

werden. So typische leichte Latenzen, die man spürt, wenn man auf geteilten Servern

Wordpress oder auch Joomla administriert, sind hier überhaupt nicht zu

erfahren. Alles läuft flott und ohne Hänger. Möglicherweise ist das der große

Vorzug gegenüber etablierten Systemen und Basistechnologien wie PHP.Die von mir verwendete Version Ghost 0.3 bringt bereits eine

RSS-Funktion und Social Share-Features mit. Es ist ein Template in den

Installationsdateien vorhanden, das sich interessanterweise responsiv verhält,

also auch auf meinem iPhone 4S sehr schnell und anders umgebrochen angezeigt

wurde und von der Aufteilung und der Ästhetik her an Google Plus erinnert. Es gibt

aber auch schon eine Hand voll anderer Themes. Sogar schon einige Plugins gibt

es, u.a. für eine Migration von WordPress auf Ghost via eines JSON Files.Serverseitiges Javascript scheint Performancevorteile zu bringen

Momentan gibt es in Ghost nichts, was WordPress und Co nicht

auch könnten. Spannend wird es, wenn es um die Performance geht. Ghost läuft

viel flüssiger, möglicherweise aufgrund der Node.js Basistechnologie, die ja

bekanntermassen auf einer ressourcenschonendes Javascript-Laufzeitumgebung

basiert oder auch nur deshalb, weil in Ghost noch nicht so viel „drinsteckt“

wie in WordPress. Ich vermute aber, Node.js hat an der Performance einen großen

Anteil.Keine Chance mit Shared Hosting

Dennoch kann Node.js am Beispiel von Ghost nun zeigen, was

es kann: Am PC ist Ghost genauso flüssig zu bedienen wie Mircosoft Word, wobei

ich mit dem eigentlich sonst recht behäbigen virtuellen Server auf einer mit

einem XEON Quadcore mit 3,20 GHz-Takt und 12 GB RAM bestückten Maschine verbunden

bin, die wohl irgendwo in einem Datacenter in Strassbourg steht. Zumindest habe ich den Eindruck, dass Node.js

hier wirkliche Experience-Vorteile liefert, sowohl für den Administrator als

auch für den User, der durchs Blog surft.Die Macher von Ghost arbeiten an einem hosted Service wie

blog.wordpress.com. Aber auch für viele andere Hostingdienste gibt es bereits

fertige Images, wie zum Beispiel für Amazon oder Rackspace.Über ghost: https://en.ghost.org/ -

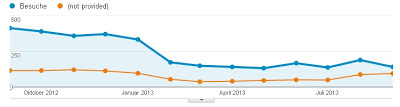

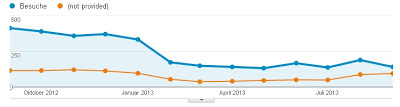

„Not provided“: Bald gibt es keinen Such-Keywordbericht mehr

Im amerikanischen Blog von searchengineland.com war es bereits zu lesen: Google wird – mit der Argumentation, die Google-Such in Zeiten von PRISM, diskreter zu machen – keine Reports mehr ermöglichen, die erkennen lassen, mit welchen Suchbegriffen die Besucher auf die eigene Website gelangt sind.

Der Anteil der nicht zuordenbaren Suchanfragen, die in Google Analytics mit „not provided“ ausgewiesen werden, ist in den letzten Monaten kontinuierlich gestiegen. Die Kurve der besuche durch die organische Suche und die Kurve für die anzahl unbekannter Suchbegriffe nähert sich kontinuierlich an, wie jeder in seinem Analytics Konto nachvollziehen kann:

Bald wird der Anteil nicht zugeordneter Suchbegriffe 100 Prozent betragen. Das hat Google inzwischen auch bestätigt.

Google bezeichnet diese Änderung als eine „Post-PRISM“-Maßnahme:

http://searchengineland.com/post-prism-google-secure-searches-172487Kaum einer nimmt Google ab, dass man sich tatsächlich hauptsächlich Sorgen um den Datenschutz der Nutzer macht.

Der wahre Grund, so vermuten viele, könnte eher der Versuch sein, das Adwords-Programm weiter zu beflügeln. Wer Adwords bucht, erhält nach wie vor Angaben darüber, mit welchen Suchbegriffen die User auf der Website landen. Natürlich kostet Adwords Geld – pro Klick eine Summe, die hauptsächlich davon abhängt, wie viele andere Anbieter Anzeigen präsentieren wollen, die erscheinen, wenn jemand mit einem festgelegten Keyword oder einer ganzen Phrase etwas mit Google sucht.

Auch in den Google Webmaster Tools werden Suchbegriffe gezeigt, die dazu führen, dass die entsprechende Domain in der Suchergebnisliste auftaucht. Die Darstellung ist aber eine andere: Gezeigt wird nicht, welche Treffer der User in einer Suchergebnisliste geklickt hat, sondern welche Keywords zu einer Ausweisung als Suchtreffer geführt haben. Damit verliert sich aber die Spur. Als Seitenbetreiber kann man nicht mehr verfolgen, welche Keywords für eine Conversion wichtig sind.

Was bleibt also, um Recherche nach wichtigen Keywords zu betreiben?

Man muss die Google Suchergebnisseiten nach eigenen relevanten Keywords durchsuchen und ermitteln, welche URL als Suchergebnis gezeigt worden ist. Das heißt, man muss massenhafte Anfragen an Google schicken und die Suchergebnisse auf die eigene Domain filtern. Oder entsprechende Tools benutzen, die aber durch die Bank Geld kosten. Ausserdem mag Google kein „Scraping“ seiner Suchergebnisseiten.Zudem kann man die Angaben aus Analytics mit denen aus den Webmastertools vergleichen. In den Webmastertools werden Impressions und Clicks für die Top-Keywords gezeigt. Was für die Webmastertools die „Clicks“ sind, ist für Analytics ein „Visit“.

Offensichtlich liefern die Webmastertools nach wie vor Keyword-Daten, wenn auch stärker vergröbert als Analytics dies tat. Nun könnte man durch geschicktes Parallelreporten und Vergleichen versuchen, den Block „not provided“ oder künftig „organic“ aufzulösen.

-

Psychologie: Warnhinweise auf Produktverpackungen können Verkäufe sogar erhöhen

Verkehrte Welt: Eigentlich sind die gesetzlich vorgeschriebenen Aufschriften wie „Rauchen kann töten“ auf Zigarettenpackungen dafür gedacht, Leute davon abzuhalten, Zigaretten zu konsumieren.

Die Wirkung der drastischen Texte, die vor dem Produkt warnen,kann allerdings paradox sein: Der Psychologe Ziv Camon hat einen Effekt gefunden, nach der Konsumenten die Produkte positiver bewerten, wenn es einen gewissen zeitlichen Abstand zwischen dem Warnhinweis und der Kaufentscheidung gibt. Die Verkaufszahlen können so ironischerweise befeuert werden.

In einem vierteiligen Experiment hat man ermittelt, dass Versuchpersonen, die Raucher waren, und die entsprechende Warnhinweise gesehen hatten, erwartungsgemäß weniger Zigaretten kauften, wenn Sie unmittelbar danach die Gelegenheit hatten.

In einer Vergleichsgruppe, in denen die Versuchspersonen Warnhinweise zu sehen bekamen, aber erst einige Tage später Zigaretten kaufen konnten, zeigte sich ein anderes Bild: Unter diesen Umständen haben die Versuchspersonen mehr Zigaretten verkauft.

Man fragt sich also, wie dieser Effekt denn zu erklären ist. Ein Vorschlag von Camon und seinem Forschunsgteam beruht auf der Annahme, dass mit der zeitlichen Distanz die Gefahr abstrakter erscheint und die Warnhinweise stärker als eine Art Signal für das fürsorgliche Verhalten des Herstellers betrachtet wird.

Der Artikel über die Forschungsarbeit ist hier erschienen:

http://www.psychologicalscience.org/index.php/news/releases/warning-of-potential-side-effects-of-a-product-can-increase-its-sales.html -

Black Hat SEO Methode im Trend: Websites hacken, um Links zu platzieren

Besondere Vorsicht ist derzeit geboten, wenn Ihr für die

Website ein CMS einsetzt.Ich sehe auf meiner Website zunehmend mehr blinde Anfragen

auf URLs mit dem Referrer „baidu.com“. Die Zugriffe gehen auf bekannte

Admin-URLs von verbreiteten und nicht so verbreiteten Content Management

Systemen.Hier sind einige Beispiel von Zugriffen, die ich in den

vergangenen 24 Stunden gesehen habe:http://www.kaekenmeister.de/images/default/publict.csshttp://www.kaekenmeister.de/HX_login.asphttp://www.kaekenmeister.de/templates/main/default/space_reviews.htmhttp://www.kaekenmeister.de/install.phphttp://www.kaekenmeister.de/www/admin/templates/install/register-step.htmlhttp://www.kaekenmeister.de/cuteeditor_files/Scripts/spell.jshttp://www.kaekenmeister.de/css/eyou.csshttp://www.kaekenmeister.de/index.phphttp://www.kaekenmeister.de/core/modules/article/assistant/templates/article_list.htm… und viele viele mehr.Alle führten auf 404, so dass ich das zeitnah mitbekomme. Ich denke aber, es gibt viele Webseitenbetreiber, denen würde eine Veränderung Ihrer Site gar nicht so schnell auffallen.Leider werden die IP Adressen bei meinem Hoster aus Datenschutzgründen nicht in den Logfiles gespeichert, so dass ich den IP Adressblock nicht einfach weg filtern kann. Und

wenn die Anfragen von einem Botnetz kommen, dann hilft das sowieso nichts.Die Anfragen so gezielt, dass ich befürchten muss, dass man

auch in meinem CMS eine Schwachstelle findet.Was also könnte helfen?Da meine Website sich nur an deutsche User richtet, könnte

ich den Zugriff aus asiatischen, chinesischen, russischen IP-Adressblöcken per .htaccess

Datei sperren. Das scheint mir jetzt etwas übertrieben zu sein.Ich möchte

lieber eine gemeinsame Eigenschaft dieser Anfragen nutzen: Alle Anfragen kommen

mit dem Referrer baidu.com, der chinesischen Suchmaschine. Es scheint also ein

Hackertool geben, das diesen Referrer

als Standardeinstellung hat. Also versuche ich, den Traffic jetzt mit der

.htaccess Datei so zu blockieren:order allow,denydeny from .baidu.comallow from allDie Aufrufe haben offensichtlich das Ziel, a) festzustellen,

welches System läuft und b) potentiell vulnerable Elemente in einem

Zielverzeichnis zu finden. Wenn eine als verletzlich bekannte Datei gefunden

wird, erhält der anfragende Client eben „sucess“ und nicht 404. Dann kann das

Hacktool hier weitermachen.Wahrscheinlich werden viele Websites überhaupt nicht so

stark verändert, dass schadhafte Codes ihrer Wirkung entfalten können – wie etwa

eine Phishingseite zu platzieren. Ich denke, dass die Hackscripts versuchen,

einige Links zu platzieren. Die werden dann verkauft. Das kann aussehen wie auf

dieser Seite:Ein völlig automatisiertes, algoritmisches Verfahren also.Es wird wohl nur helfen, immer wieder ein Backup herzustellen und immer die neuste Version des CMS zu verwenden. Ansonsten gibt es seit einiger Zeit die S-Initiative vom Branchenverband eco, Bundeswirtschaftsministerium und einigen Internetfirmen. Man kann sich dafür kostenlos anmelden, einen Securitycheck ausführen zu lassen. S-Initiative schickt dann täglich einen Crawler auf die Website und sendet eine E-Mail, falls schädliche Code-Elemente auf der Startseite gefunden werden. -

Kommt die Nischengesellschaft wieder?

Die Ausfrage diese Post war, wie es sich auf die Gesellschaft im Sinne von Verhaltensänderung ihrer Mitglieder auswirkt, wenn alle sich bewusst sind, permanent mit allen Internet- und Mobile-Aktivitäten überwacht werden zu können.

Gar nicht ist die eine Hypothese, die man öft hört und die sich vielleicht mit der Phrase „ich habe nichts zu verbergen“ pointieren lässt.

Meine These war, das Kommunikationsverhalten ändert sich langsam, aber nachhaltig, was gesellschaftliche Auswirkungen haben kann. Es bilden sich womöglich Nischen, so wie man Nischen in autoritären, hoch-kollektivistischen Gesellschaften kennt.

Eine solche Nische könnte das sein, was Telepolis mit „Darknet“ bezeichnet.

UPDATE 29.7.2013 – Telepolis Beitrag zum „Darknet“

Es gibt keine eindeutige Definition davon, was man mit „Darknet“ meint. Letztendlich scheinen solche Zuschreibungen wie „verschlüsselt“, „nicht durchsuchbar“, „abgetrennt vom ’normalen‘ Internet“.Zitat:

Einem notwendigen, verlässlichen, rechtsicheren, vertrauenswürdigen

kommerzialisierten und überwachten Teil (dem „Internet“) und einem

unzuverlässigen, rechtlosen, anonymen, dafür freien und nicht

zensierbaren Teil (dem „Darknet“, optimalerweise so konstruiert, das

seine Nutzung abstreitbar ist).UPDATE 22.07.2013 – der Freitag hat eine ähnliche Geschichte veröffentlicht.

http://www.freitag.de/autoren/der-freitag/uns-steht-eine-neue-netzguerilla-bevorDer Autor sieht aber eher eine Art Radikalisierung, weniger einen Rückzug und nimmt Bezug auf Cypherpunks von Julian Assange, Jacob Appelbaum, Jérémie Zimmermann und Andy Müller-Maguhn:

Nur „eine Elite von High-Tech-Rebellen“, heißt es in Cypherpunks, sei in der Lage, sich dem „Moloch Überwachungsstaat“ zu entziehen.

und weiter:

Vielleicht müssen wir das Internetzeitalter künftig in eine Zeit vor und

in eine Zeit nach Snowden einteilen. Die Zeit der Happenings und des

spielerischen Umgangs mit dem Netz ist jedenfalls vorbei. Den

Netzpolitikern, die seit Jahren mit zäher Kleinarbeit und demokratischen

Mitteln für ein freies Internet kämpfen, erwächst daraus eine neue

Verantwortung: Sie müssen den radikalisierten Gruppen – die sich mit

Kleinkram nicht mehr abspeisen lassen werden – eine überzeugende

Alternative anbieten.Warum eigentlich passiert gerade keine Revolution? Warum lassen sich die Untertanen die Überwachung offensichtlich gefallen und der Regierung jede Nicht-Aktivität in dieser Angelegenheit durchgehen? Das fragt sich unter anderem Jakob Augstein in seiner Rubrik auf Spiegel online.

Faulheit, Bequemlichkeit, sagen die einen. Fehleinschätzung, sagen andere, zum Beispiel Sascha Lobo. Es ginge um nichts geringeres als den freien Willen, so Viktor Mayer-Schönberger in der Zeit.

Wir fühlen uns nicht durch Algorithmen bedroht, weil wir zur Zeit kein Unterdrückungsregime sehen, das dieses potentielle Machtinstrument gegen die Bevölkerung einsetzen will. Dennoch ist es sehr erstaunlich, dass die Haltung „Ich habe nichts zu verbergen“ oder „ist doch nicht schlimm“ im gleichen Kulturkreis der Häuserverpixeler artikuliert wird. Die Deutschen sind doch eigentlich alles andere als transparent, wenn es um Gehalt oder Reichtum geht. Das darf doch keiner wissen, höchstens erahnen, um den gesellschaftlichen Status zu proklamieren (man trägt Rolex, fährt einen SUV). Biedermann und die Brandstifter.Überwachung riecht man nicht und sieht man nicht

Außerdem haben wir Menschen keine Sinne dafür, wir können Ursache und Folge der Entwicklung nicht abschätzen, weil diese zeitlich weit auseinanderliegen und wenig linear zusammenhängen.Manche reagieren darauf mit Angst, andere – offensichlich die meisten – mit Ignoranz. Hätten wir Sinne für die Gefahr der Überwachung, zum Beispiel, dass schwarzer, übelriechender Qualm aus der Tastatur austritt, wir würden sofort reagieren.Reaktion wird erfolgen

Ich denke, die internetnutzende Bevölkerung wird reagieren, so wie einige (wenige) anfangen, ihre Daten zu verschlüsseln, US-Anbieter zu meiden oder sich sogar Gedanken machen, inwiesweit sie ihren Internettraffic beeinflussen können. Ein Tool zum Tracen und Visualisieren der Route gibt es bei Opendatacity.de

Wir wissen jetzt, dass viele Stellen mithören können, algorithmisch, auch nachträglich. Lässt uns das kalt? Schleichend aber sicher werden wir die naive Begeisterung an Social Media und Smartphone Apps verlieren, weil wir wissen, die Beschäftigung damit kann gegen uns verwendet werden, eines Tages vielleicht.Privates wird wieder privater. Wir bloggen nicht mehr über kritische Einsichten, wir teilen keine schwer verständlichen Stimmungen oder Bilder mehr, weil wir den Adressatenkreis nicht mehr kennen und abschätzen können.

Nischengesellschaften

Wir unterscheiden wieder: Hier das Öffentliche oder Halböffentliche, hier das Private. Die Frage ist nur – wie findet das Austauschen des Privaten statt? Das Öffentliche wird Kommunikation zweiter Klasse. Nischengesellschaften entstehen, vielleicht wie damals in der DDR mit der allgegenwärtigen Überwachung durch die Stasi und ihre IMs, vermeintliche Freunde und Kollegen. Jeder Brief, jedes Telefonat, jedes Treffen überwacht.

Ende von Social Media?

Wahrscheinlich bilden sich Zufluchten und Zirkel, in der es keine elektronische Kommunikation gibt. Für die Social Community Idee wird dies ein heftiger Rückschlag werden. Die Idee, Einsichten, Ideen, Erfahrungen mit einem ausgesuchten Kreis zu teilen, wird leiden. Social Media Plattformen werden komplett zur Promotionmaschine, nicht weiter. Schade eigentlich.

Meetings statt Videokonferenzen

Firmen werden wieder auf das direkte Gespräch setzen, auf Besprechungen, bei denen Datenbrillen verboten sind. Videokonferenzen, teilweise als das Heil gegen teuere Geschäftsreisen gefeiert, werden eine Renaissance erleben und dem Staat traut man wieder ein Stück weniger.

Privatleute treffen sich in sehr privaten Räumen. Das muss geplant und anvisiert werden. Big Brother sieht die Aktivitätszunahme, kennt aber nicht mehr den Inhalt. Ein menschlicher Spion müsste los.

Subnets und private Netze

Daneben, neben dem großen Kommerzweb entstehen neue Netze dadurch, dass sich Enthusiasten oder Untergrundaktivisten zusammenschalten. Direct Connect könnte ein Beispiel dafür sein.Es wird eine Revolution stattfinden, aber keine schnelle. Keine, die von heute auf morgen Spuren hinterlässt und Auswirkungen augenfällig macht. Die Begeisterung für Cloudcomputing wird schwinden, wir setzen wieder auf installierte Software und physikalisch verfügbare Datenträger und geteilt wird nicht mehr. Das könnte der gerade aufkommenden Share-Economy einen gehörigen Dämpfer versetzen.

Die Umstellung dauert

Das dauert deswegen so lange, weil man sich erst wieder umstellen muss, doch der Anfang ist gemacht.

-

So wird man die Pest von „delta-search.com“ wieder los

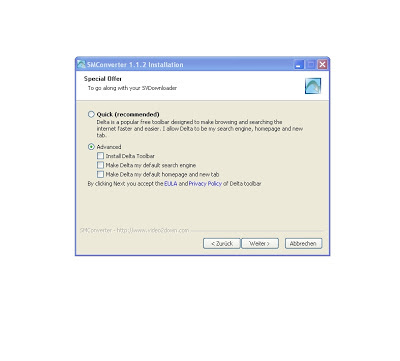

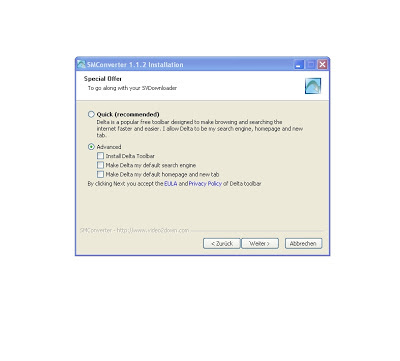

Es gibt immer mehr Freeware-Angebote, die nach dem Herunterladen und Installieren ungefragt einige zusätzliche Komponenten mitinstallieren.

Das passiert bei Downloads von CNET, Softonic und anderen Sites, denen man bisher eigentlich vertrauen konnte. Das scheint Vergangenheit zu sein. Heute heißt es: Augen auf bei der Freeware-Suche.Wichtig, wenn Sie Freeware herunterladen und installieren: Im Laufe der Installation sollte man es vermeiden, auf Schnellinstallationslinks wie „Quick Install“ zu klicken. Das kann bequem sein, aber installiert viel Unnützes und eventuell auch Gefährtliches mit.

Beim Installieren von Freeware unbedingt die „Advanced“ – Option nutzen, sonst gelangt allerlei Softwaremüll ins System. Es handelt sich oft um beliebte consumernahe Software, wie etwa Bildverabreitungstools, Formatwandler und so weiter, Dinge, die man alltäglich einfach ab und an braucht.Sogar im Advanced Installationsdialog muss man die Anweisung sehr genau lesen, sonst wird die Malware der Installation doch noch hinzugefügt. So muss man in einem Beispiel auf „no“ klicken, statt auf das gewohnte „OK“.

Augen auf auch im Installationsdialog. Sonst bekommen Sie allerhand Adware und Malware untergeschoben.

Einer der aggressivsten Malwareinstaller ist zur Zeit delta-search:– delta-search klinkt sich als Toolbar in jeden Browser, den Sie installiert haben

– außerdem wird delta-search die Standardsuche

– und weil das noch nicht reicht, macht sich delta-search zur Startseite in jedem Browser

– zusätzlich wird ein als Sicherheitstool getarntes Progrämmchen installiert, das Adware- und Malwareentfernern die Arbeit erschweren soll

Die Verbreitung aufgrund aggressiver Installationsmethoden von delta-search.com steigt rasant. Wer Delta Search betreibt, ist gar nicht so einfach herauszufinden. Weder in den T&C oder im Privacy-Statement noch über eine Whois-Abfrage ist der Inhaber der Domain zu ermitteln. Die Domain wurde über Godaddy registriert und wird von einer amerikanschen Firma verwaltet, deren Spezialität es ist, den eigentlichen Inhaber nicht preiszugeben. Das erinnert an Babylon Search, vielleicht handelt es sich ja auch um den gleichen Anbieter, der nur das Webfrontend verändert hat, nachdem diese Domain verbrannt war.

Die Identität des Domaininhabers von delta-search.com wird verschleiert. Delta Search versucht, einmal im System eingenistet, nicht weiter aufzufallen und akzeptable Suchergebnisse zu liefern.

Die Ähnlichkeit zur Google-Suchseite ist frappierend: Die Schrift, der schwarze horizontale Navigationsbalken, die Aufteilung der Seite… flüchtige User sehen noch nicht einmal den Unterschied. Und eine weitere Anzahl User wird Delta Search mehr oder weniger zähneknirschend akzeptieren, da das Deinstallieren recht aufwändig ist.

Damit der Eindruck gewahrt bleibt, zeigt delta-search.com oben rechts direkte Links zu einer Videosuche, zum Maillogin und anderen Diensten, allerdings zu denen von Yahoo!Auch die Suchergebnisse sehen bekannten SERPs (search engine result pages) zum Verwechseln ähnlich. Dennoch gibt es deutliche inhaltliche Qualitätsunterschiede im Vergleich zu Google.

Delta Search will vermutlich über die Klicks auf Suchergebnisse Umsatz generieren. International aufgesetzt und dank Malwareinstallation weit verbreitet, ist das offensichtlich ein einträgliches Geschäft.Wie aber kann man „delta-search.com“ wieder loswerden?

Es gibt einige Removal-Tools, aber auch „zu Fuß“ kann man die entsprechenden Einstellungen wieder rückgängig machen.Software deinstallieren

Zunächst sollte man die Software, die mit dem eigentlichen Hauptprogramm installiert worden ist, in der Systemsteuerung unter „Software“ de-installieren. Auch die Toolbars für die Browser kann man dort deinstallieren.

Danach nimmt man sich die Browser vor und entfernt die Einträge für die Startseite und die Suchbox.

delta-search-Entfernung aus Firefox

Bei Firefox muss man zudem noch neu einstellen, welche URL geöffnet wird, wenn man einen neuen Tab öffnet. Dies ist nach der „delta-search.com“ Installation auch verändert worden. Man tippt about:config in die Adresszeile des Firefoxbrowsers und sucht nach dem Eintrag „browser.newtab.url“. Als Status steht dort „Vom Benutzer…“. Klicken Sie rechts auf diese Worte und bwegen Sie die Maus auf den Menüeintrag „Zurücksetzen“. Dann wird der Standard wieder hergestellt.delta-search-Entfernung aus Chrome

Bei Chrome muss man unter „Einstellungen“ die Angabe „Bestimmte Seite oder Seiten öffnen“ im Abschnitt „Beim Start“ öffnen. Hier ist auch delta-search eingetragen. Man muss dies nur im Dialog „Startseiten“ löschen.

Im Abschnitt „Suche“ in den Chrome-Einstellungen muss man festlegen, welche Suchmaschine mit der Omnibox verwendet werden soll. Die Omnibox ist das Eingabefeld in Google Chrome. Dort kann man eine URL eingeben oder auch einen Suchbegriff.

Überprüfen Sie sicherheitshalb noch einmal die Einträge im Menüpunkt „Erweiterungen“ in Chrome.

Möglicherweise ist noch anderer Adware-Mist mitinstalliert worden. Ein Virenscanner kann helfen, noch weitere Elemente zu identifizieren.delta-search-Entfernung aus dem IE

Im Internetexplorer funktioniert dies ganz ähnlich:

Öffnen Sie unter dem Menüpunkt „Einstellungen“ den Punkt „Add-Ons verwalten“. Unter „Suchanbieter“ können Sie „Delta Search“ entfernen.

Schließen Sie die „Einstellungen“-Dialogseiten und klicken Sie unter „Extras“ noch auf den Menüpunkt „Internetoptionen“. Auf der Registrierkarte „Startseite“ sehen Sie den Delta-Search-Eintrag, den Sie hier entfernen können, indem Sie einfach auf „Leere Seite“ klicken. Schließen Sie den Dialog mit „OK“ ab.

Grundsätzlich sollten keine Schäden am System oder Datenverluste auftreten. Delta-Search ist vor allen Dingen lästig. Dennoch sollte man sich die Arbeit machen, eventuell vorhandene Adware- oder Malware-Elemente wieder zu entfernen.Delta-Search ist keine vernünftige, zu empfehlende Suchmaschine und man darf den Verdacht haben, dass es dem Betreiber auch darum geht, das Suchverhalten auszuspähen.Bleibt natürlich die Frage, wie kommt man an qualitative Freeware. Wer es sich leisten kann, lässt von Freeware die Finger, denn wenn Sie einen halben Tag damit beschäftigt sind, Malware zu entfernen, können Sie anhand der Zeit, die Sie vergeuden, entscheiden, ob Ihnen Bezahlsoftware nicht doch vielleicht den Preis Wert ist.Es ist verständlich, dass Freeware-Produzenten die vielen Downloads etwas monetarisieren wollen. Die Frage ist allerdings, ob Erlöse wirklich bei den Produzenten ankommen. -

Eigene Summer-Challenge: ein dahindümpelndes Webprojekt mit Content pushen

Seit einigen Jahren betreibe ich eine kleine Seite, die eigentlich ursprünglich als Testsite für Typo3 gedacht war.

Viel Zeit und Geld kann ich in dieses Projekt nicht investieren, aber ich will im Sommer 2013 nun einmal versuchen, der Domain ein bisschen Speed zu geben, allerdings nur mit Content. Ich werde keine Links organisieren oder kaufen.

Gestern mal ein paar Onsite-Dinge gemacht, schon sieht man einen Ausschlag. Mal sehen, wohin das führt.