Besondere Vorsicht ist derzeit geboten, wenn Ihr für die

Website ein CMS einsetzt.

Website ein CMS einsetzt.

Ich sehe auf meiner Website zunehmend mehr blinde Anfragen

auf URLs mit dem Referrer „baidu.com“. Die Zugriffe gehen auf bekannte

Admin-URLs von verbreiteten und nicht so verbreiteten Content Management

Systemen.

auf URLs mit dem Referrer „baidu.com“. Die Zugriffe gehen auf bekannte

Admin-URLs von verbreiteten und nicht so verbreiteten Content Management

Systemen.

Hier sind einige Beispiel von Zugriffen, die ich in den

vergangenen 24 Stunden gesehen habe:

vergangenen 24 Stunden gesehen habe:

http://www.kaekenmeister.de/images/default/publict.css

http://www.kaekenmeister.de/HX_login.asp

http://www.kaekenmeister.de/templates/main/default/space_reviews.htm

http://www.kaekenmeister.de/install.php

http://www.kaekenmeister.de/www/admin/templates/install/register-step.html

http://www.kaekenmeister.de/cuteeditor_files/Scripts/spell.js

http://www.kaekenmeister.de/css/eyou.css

http://www.kaekenmeister.de/index.php

http://www.kaekenmeister.de/core/modules/article/assistant/templates/article_list.htm

… und viele viele mehr.Alle führten auf 404, so dass ich das zeitnah mitbekomme. Ich denke aber, es gibt viele Webseitenbetreiber, denen würde eine Veränderung Ihrer Site gar nicht so schnell auffallen.

Leider werden die IP Adressen bei meinem Hoster aus Datenschutzgründen nicht in den Logfiles gespeichert, so dass ich den IP Adressblock nicht einfach weg filtern kann. Und

wenn die Anfragen von einem Botnetz kommen, dann hilft das sowieso nichts.

wenn die Anfragen von einem Botnetz kommen, dann hilft das sowieso nichts.

Die Anfragen so gezielt, dass ich befürchten muss, dass man

auch in meinem CMS eine Schwachstelle findet.

auch in meinem CMS eine Schwachstelle findet.

Was also könnte helfen?

Da meine Website sich nur an deutsche User richtet, könnte

ich den Zugriff aus asiatischen, chinesischen, russischen IP-Adressblöcken per .htaccess

Datei sperren. Das scheint mir jetzt etwas übertrieben zu sein.

ich den Zugriff aus asiatischen, chinesischen, russischen IP-Adressblöcken per .htaccess

Datei sperren. Das scheint mir jetzt etwas übertrieben zu sein.

Ich möchte

lieber eine gemeinsame Eigenschaft dieser Anfragen nutzen: Alle Anfragen kommen

mit dem Referrer baidu.com, der chinesischen Suchmaschine. Es scheint also ein

Hackertool geben, das diesen Referrer

als Standardeinstellung hat. Also versuche ich, den Traffic jetzt mit der

.htaccess Datei so zu blockieren:

lieber eine gemeinsame Eigenschaft dieser Anfragen nutzen: Alle Anfragen kommen

mit dem Referrer baidu.com, der chinesischen Suchmaschine. Es scheint also ein

Hackertool geben, das diesen Referrer

als Standardeinstellung hat. Also versuche ich, den Traffic jetzt mit der

.htaccess Datei so zu blockieren:

order allow,deny

deny from .baidu.com

allow from all

Die Aufrufe haben offensichtlich das Ziel, a) festzustellen,

welches System läuft und b) potentiell vulnerable Elemente in einem

Zielverzeichnis zu finden. Wenn eine als verletzlich bekannte Datei gefunden

wird, erhält der anfragende Client eben „sucess“ und nicht 404. Dann kann das

Hacktool hier weitermachen.

welches System läuft und b) potentiell vulnerable Elemente in einem

Zielverzeichnis zu finden. Wenn eine als verletzlich bekannte Datei gefunden

wird, erhält der anfragende Client eben „sucess“ und nicht 404. Dann kann das

Hacktool hier weitermachen.

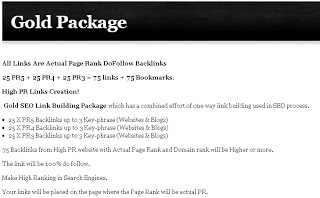

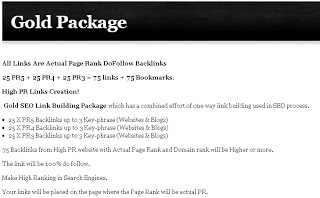

Wahrscheinlich werden viele Websites überhaupt nicht so

stark verändert, dass schadhafte Codes ihrer Wirkung entfalten können – wie etwa

eine Phishingseite zu platzieren. Ich denke, dass die Hackscripts versuchen,

einige Links zu platzieren. Die werden dann verkauft. Das kann aussehen wie auf

dieser Seite:

stark verändert, dass schadhafte Codes ihrer Wirkung entfalten können – wie etwa

eine Phishingseite zu platzieren. Ich denke, dass die Hackscripts versuchen,

einige Links zu platzieren. Die werden dann verkauft. Das kann aussehen wie auf

dieser Seite:

Ein völlig automatisiertes, algoritmisches Verfahren also.

Es wird wohl nur helfen, immer wieder ein Backup herzustellen und immer die neuste Version des CMS zu verwenden. Ansonsten gibt es seit einiger Zeit die S-Initiative vom Branchenverband eco, Bundeswirtschaftsministerium und einigen Internetfirmen. Man kann sich dafür kostenlos anmelden, einen Securitycheck ausführen zu lassen. S-Initiative schickt dann täglich einen Crawler auf die Website und sendet eine E-Mail, falls schädliche Code-Elemente auf der Startseite gefunden werden.

Kommentar verfassen