Etracker ist eigentlich ein gutes Webanalyse-Tool. Ich bin wahrscheinlich das, was man einen Poweruser nennt: Ich zähle zur Zeit über 5.200 Logins in 5 Jahren, da macht im Schnitt über 2,5 Login pro Tag – egal ob Montag, Sonntag oder Feiertag. Prinzipiell bin ich mit etracker sehr zufrieden. Doch ein paar Einschränkungen bei der Möglichkeit, Daten direkt mit dem Tool zu analysieren oder roh zu exportieren, nerven mich.

Ich Controller mit etracker eine E-Commerce-Seite, die Kunden aus dem Web direkt generiert (Kunden füllen ein Bestellformular aus und schließen eine Art Abo ab).

Die große Konkurrenz für das in Hamburg ansässige etracker heißt Google Analytics. In der einfachen Version ist Analytics kostenlos, genauso wie die Google Webmaster Tools, mit denen Analytics zusammenspielt, wenn man als User die Freigaben entsprechend einrichtet. Etracker kostet – abgesehen von einer wirklich nur zu Testzwecken einsetzbaren Variante – vom Start weg Geld. Wieviel hängt vom Volumen an Besuchern ab. „Touchpoints“ heißt diese Größe bei etracker.

Für den täglichen Gebrauch, zur Messung aktueller Aktivitäten auf den verschiedenen Domains, für das Aufsetzen von Trackings ist etracker wirklich super.

Schön, dass man Segmente aus Zielgruppen bilden kann (z.B. Nichtkunden, Sticky User, die lange auf der Webseite bleiben usw.). Diese Segmente kann man gut anwenden, wenn man die Besuchsaktivität auf der Site untersuchen möchte.

Leider ist die Betrachtung der Webbesuchsaktivität komplett getrennt von den Konversionszielen. Abgesehen von Kampagnen, die mit Parametern an der URL oder über Cookies getrackt werden, kann man Anzahl an Konversionen (Leads, Sales; Webseitenziele, wie es bei etracker heißt) nachträglich nur schwer miteinander vergleichen.

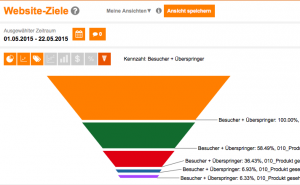

Ich bin erst jetzt wieder auf diese Tücken gestoßen. Das kam so: Auf der betrachteten Webseite bewegen sich Bestandskunden (über 90 Prozent der gesamten Besucher) und interessierte User, die wir als potentielle Kunden betrachten (wir bildeten das Segment der „Nichtkunden“, die wir als potentielle Kunden betrachten, einfach als Restmenge der Mengen „Alle Besucher“ minus „Bestandskunden“). Die Bestandskunden werden durch ihr Verhalten auf der Site als solche erkannt (z.B. durch Besuch von Loginseiten).

Für das Kundengewinnungsmarketing und die vertriebliche Ausrichtung von Werbekampagnen ist die Nichtkundengruppe natürlich besonders interessant.

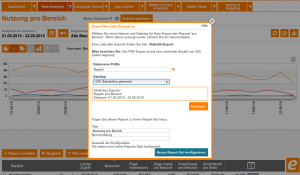

Ich wollte nun eine Zeitreihe generieren, die mir die Anzahl der Besuche von Nichtkunden auf bestimmten Landeseiten oder Produktseiten (in der etracker-eigenen Bezeichnung heißen diese Seiten „Bereiche“) im Vergleich zu den Gesamtsales pro Tag zeigt. Eigentlich klingt das einfach.

Ich wollte Bestätigung für die Annahme, dass diese Bereiche für die Neukundengewinnung besonders wichtig sind: Mehr (organischer) Nichtkunden-Traffic auf diesen Seiten sollte zu mehr Konversionen führen – wenn der Traffic relevant ist. Relevanten Traffic will ich dabei mit Content Marketing gewinnen: Es werden Artikel platziert, die in Social Media Plattformen geteast werden, geliked und geshared werden, wobei die zentrale URL (z.B. mit einem Call to Action) auf eine Landeseite führt, die aber ein Blogbeitrag oder eine Produktseite sein kann.

Genau so eine recht einfache Nebeneinanderstellung von KPIs als Zeitreihe lässt sich mit etracker nur sehr schwer realisieren: Man muss die Anzahl der Sales exportieren (pro Tag bzw. pro Sale mit Datums- und Zeitangabe), danach exportiert man die Anzahl der Besucher pro Bereich. Dabei liefert etracker hier nur den „letzten Zugriff“ als Datum. Man müsste also Tag für Tag (Zeitraumeingrenzung) exportieren, was bei einem halben Jahr viel manueller Aufwand ist. Die Zeitreihe lässt sich zwar am Bildschirm anzeigen, aber nicht exportieren.

Hier werden nur die Summen des gesamten Zeitraums geliefert. Die Zeitreihe muss dann in Excel wieder zusammengesetzt werden. Erst dann kann man analysieren.

Wenn man Daten auf Wochenbasis oder Monatsbasis gleich aggregiert exportieren möchte, mag das gehen. Will man aber die Daten möglichst granualar exportieren, also auf Tagesbasis, wird man jeden Tag als Zeitraum definieren müssen. Mir ging es dabei auch darum, festzustellen, wie sich einzelne Wochentage verhalten. Und es mag ein Unterschied sein, ob man sich am Monatsanfang oder in der Monatsmitte befindet.

Alternativ kann man über die Einzeldarstellung gehen und diesen Bericht exportieren. Das geht etwas schneller, dafür kann man eben nur einen Bereich exportieren, aber nicht zum Beispiel eine Seitengruppe, die man mit einem Filter gefiltert hätte.

Natürlich kann man auch einen Bereicht „Pro Tag“ oder „Pro Woche“ ausgeben, aber dann nur mit der Gesamtzahl aller Besucher und PageImpressions über alle Domains, Bereiche und Seiten hinweg ohne dass man auch Bereich oder auch nur einzelne Seiten filtern könnte.

Andererseits muss man sagen: Mittels Kampagnen kann man sehr gut tracken. Natürlich könnte man nun jeden geshareten Social Media Link entsprechend mit einem Parameter ausstatten, genauso wie Links aus dem Corporate Blog, die auf Produktseiten führen, so dass Konversionen durchgetrackt werden können. Die Gefahr, dass man sich dann mit den Parametern sehr verzettelt ist groß. Die Skalierung ist sozusagen entsprechend aufwendig. Und zudem kann man mit diesem Verfahren nicht in einen Vergleichzeitraum zurückblicken, in dem die Parameter noch nicht gesetzt waren. Darum ging es mir hier in diesem kleinen Projekt.

Bleibt mir die Frage: Warum muss ich das so umständlich machen und warum darf ich die Besuchdaten pro Tag in einer Zeitreihe nicht mit der Anzahl der Sales oder Leads pro Tag für einen Zeitraum von mehreren Monaten matchen (vergleichen)?

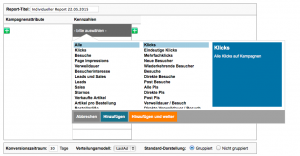

Das verleidet die Analyse mit etracker Daten etwas. Die im zusätzlich buchbaren „individuellen Reports“ nutzen Daten aus dem Campaigning und verwenden die „et_Tags“, die man Kampagnenlinks etc. mitgibt.

Im Analysebereich könnte etracker nachbessern. Das Webfrontent muss ja nicht alle möglichen Funktionen abbilden, aber wenigstens exportierbar sollten solche Daten schon sein. Da finde ich Google Analytics besser. Eine solche Auswertung wie oben lässt sich recht einfach im Tool machen.

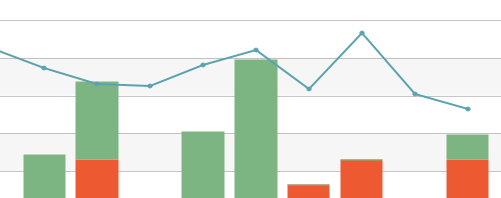

Um kurz über die Ergebnisse zu sprechen: Ich wollte sehen, wie verschiedene Webseitenbereiche mit Konversionen (Sales) zusammenhängen. Dies sollte Aufschluss geben, ob Content Marketing sich direkt auf die Sales auswirkt. Dafür wollte ich ein Modell finden, wobei ich zuerst ein paar Korrelationsanalysen gemacht habe.

Natürlich gibt es viele Faktoren, die die Konversion beeinflussen und die Wahrscheinlichkeit heben oder senken. Hier einige Ergebnisse:

- Zwischen der Besucheranzahl auf dem Corporate Blog und dem Salesanzahlen auf Tagesbasis konnte ich eine Korrelation von r=.24 finden.

- Zwischen dem Besuchertraffic auf Contentseiten (Glossar), konnte ich einen etwas stärkeren Zusammenhang feststellen, nämlich r=.30

- Der Wochentag macht viel aus, wenig überraschend die Tatsache, dass ein negative Zusammenhang mit dem Bestelleingang zu verzeichnen ist, wenn der betrachtete Tag ein Samstag oder Sonntag ist (r= -.32).

- Wenn man die einzelnen Kriterien und die Salesanzahl als abhängige Variable korrelativ untersucht erreicht man Korrelationen um .38. Mit anderen Worten: Noch nicht einmal 15 Prozent der gemeinsamen Varianz lassen sich durch Besucherzahlen auf spezifischen Seiten erklären.

- Ich hatte gehofft, durch die Betrachtung des Besucherverhaltens deutlichere Hinweise darauf zu erhalten, auf welche Kernseiten man Besucher lenken müsste, damit sie mit höherer Wahrscheinlichkeit etwas kaufen. In Grenzen funktioniert dies ja auch, aber so 30 Prozent an Aufklärung gemeinsamer Varianz wäre schön gewesen.

Mit diesem Wissen versuchte ich noch eine Regressionanalyse. Ich suchte nach einem linearen Modell und war gespannt, welche Gewichte die einzelnen Kriterien in die Gleichung bringen.

Natürlich erreiche ich auch damit nur ein R² von 0,16. Grund: Die einzelnen Kriterien kovariieren recht stark. Da braucht man sich nicht zu wundern, dass weitere Kriterien nur wenig zusätzliche Varianzaufklärung mitbringen.

Das dem Betrag nach größte Betagewicht der gefundenen Regressionsgleichung liefert die logistisch kodierte Variable, die angibt, ob es sich um einen Wochentag handelt. Des weiteren fallen die die Seiten auf, die das Produkt darstellen und die das Call-to-action Element beinhalten („jetzt bestellen“).

Es gibt, wie gesagt, viele versteckte Kriterien, die hier nicht eingehen:

- Relevanz: Wie relevant zur Kaufentscheidung ist der Inhalt, der in Blog und anderen Contentseiten im Einzelfall für ein Suchwort oder ein social Media Share gezeigt ist?

- Wetter: Eine frühere Analyse zeigte große Abhängigkeiten.

- Konkurrenz: Dies wird hier überhaupt nicht modelliert (Preise, Produkte…). Ich würde dieses Kriterium als sehr wichtig einschätzen, aber ich habe noch keinen praktikablen Weg gefunden, dies zu modellieren bzw. Daten zur Verfügung zu haben.

Kommentar verfassen