Google wehrt sich gegen eine Initiative der französischen Regierung wonach die Suchmaschinenbetreiber eine Abgabe an Verlage zahlen müssen, wenn auf den Ergebnisseiten Links zu Content der Verlage führen. Wie der Focus (Burda-Verlag) berichtet, handelt es sich um eine ähnliche Gesetzesinitiative wie dem Leistungsschutzrecht für Presseverleger. Offensichtlich lässt Burda zur Zeit ohnehin gegen Google feuern, wenn man sich die kritischen, aber doch überzogene Betitelung bei Focus Online Beiträgen der letzten Zeit ansieht: Sei es die Ausweidung der Panne mit den Geschäftszahlen und dem Aktienkurs („Peinliche Bilanz-Panne“ und „Derber Bilanz-Patzer bei Google: Rasante Fahrt in den Keller“), Datenschutz („Google zwingt User zu Daten-Striptease“) oder der Fall Wulff („Google – die neuzeitliche Rufmordmaschine“). Ein alter Streit flammt jetzt heftig auf.

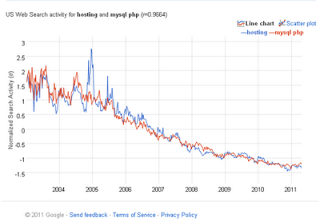

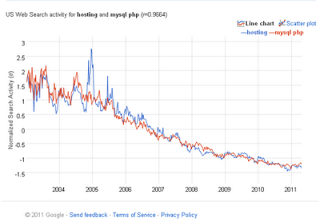

Natürlich gibt es eine Abhängigkeit von Google. Das gilt für jeden Webseitenbetreiber und das gilt auch für Webseiten etablierter Medien. Warum probiert Burda nicht mal aus, wie sich der Traffic ohne die Sichtbarkeit in den Suchmaschinen entwickelt und ob nicht eine eigene inhaltlich ausgerichtete eigene Suchmaschine für die Verlagsangebote sinnvoll wäre? Genauso wie bei den 154 brasilianischen Zeitungen sollte ein entsprechender robots-Eintrag eigentlich reichen, um das Spidern und Ausliefern entsprechender Suchmaschinenergebnisse bei Google zu verhindern. Nach Alexa ist focus.de auf Traffic-Rang 34 in Deutschland und zwischen 15 und 20 Prozent der Zugriff kommen aus Suchmaschinen. Focus hat also – im Gegensatz zu vielen anderen Webseitenbetreibern – genug alternative Trafficquellen und könnte auf die 20 Prozent, die von Google kommen, vielleicht sogar verzichten, auch wenn die Konkurrenz spiegel-online.de noch weniger abhängig von Google zu sein scheint (was die Alexa-Zahlen nahelegen)

Eine Sonderabgabe, die den jammernden deutschen Verlagen zugute kommt, die wenig und zu spät ins Webgeschäft investiert haben (dann zudem auch noch recht glücklos bis unbedarft agiert) und das Geschäft eben verpasst haben, geht stark in Richtung Subvention. Durch die Sonderabgabe verteuern sich wahrscheinlich die Klickpreise für Google Adwords, so dass andere Werbetreibende mehr zahlen müssen, was diese dann in ihre Produktpreise kalkulieren müssen, so dass die Verteuerung eh bei den Verbrauchern ankommt. Klar, dass die Verleger darum kämpfen und ihre publizistische Macht entsprechend einsetzen. Doch Umverteilungsmonster wie die Gema passen einfach nicht mehr in die Zeit.